De belles images avec le cerveau : tout ce qui brille n’est pas or !

Publié en ligne le 19 mars 2022 - Cerveau et cognition -

Le développement des techniques d’exploration fonctionnelle cérébrale est à l’origine de nombreux titres à sensation : « On a localisé Dieu dans le cerveau ! » (remplacez ici « Dieu » par toute autre entité ou fonction, y compris « sexe », que vous jugerez intéressante). Mais la fiabilité de ces travaux est-elle au rendez-vous ? Un article récent [1] nous invite à en douter. L’étude qu’il rapporte montre qu’un jeu unique de données issues de l’imagerie cérébrale fonctionnelle peut donner lieu à des résultats différents selon le choix de la méthode de traitement du signal par les équipes de chercheurs, ce qui suggère que le traitement des images pourrait être orienté à volonté vers les résultats attendus ou souhaités. La réalité est plus nuancée.

Les neurosciences doivent une grande partie de leur succès médiatique au pouvoir extraordinaire de fascination exercé par les images, ainsi qu’à une position réputée dominante dans le champ des sciences de l’Homme en raison de l’objectivation de processus mentaux qu’elles sont supposées apporter. À partir de la fin des années 1980, la possibilité de « voir ce qui se passe dans la tête » lors de l’exécution de différentes activités (les « tâches ») a conduit les chercheurs à rivaliser d’ingéniosité dans la conception de protocoles expérimentaux et, en parallèle, à raffiner les outils d’analyse des signaux produits par la neuro-imagerie. Des associations étaient alors mises en évidence entre certains processus du traitement cérébral de l’information et l’activation de régions cérébrales spécifiques (ou, plus souvent, de réseaux d’aires cérébrales). Ainsi, la vision est associée à une activation des aires occipitales, le mouvement volontaire au cortex moteur correspondant, etc. Bien qu’il existe différentes techniques d’imagerie cérébrale fonctionnelle, la plus représentée, et celle dont il sera question dans cet article, est l’imagerie par résonance magnétique fonctionnelle (IRM fonctionnelle, voir encadré ci-dessous).

Principes généraux

Une exploration fonctionnelle permet d’examiner la manière dont un organe particulier fonctionne (ou dysfonctionne), et se distingue donc de l’exploration anatomique qui se contente d’examiner la structure de l’organe. Pour le cerveau, on parle d’exploration fonctionnelle cérébrale. Ce type d’analyse peut être fait dans un but diagnostique en situation clinique, mais il peut aussi servir dans un objectif de recherche pour comprendre les mécanismes à l’œuvre dans des tâches motrices, sensorielles ou cognitives. En réalité, l’imagerie fonctionnelle de « tâche » (ou « d’activation ») n’est que l’une des modalités possibles de l’imagerie fonctionnelle cérébrale. À la fin des années 1990, le chercheur américain Markus Raichle a montré qu’il était possible de réaliser une imagerie fonctionnelle « de repos », sans qu’aucune tâche spécifique ne soit demandée au sujet de l’expérimentation [1]. Cette façon d’étudier le cerveau a ouvert de nouvelles perspectives, notamment parce qu’il devient possible d’identifier des « signatures fonctionnelles » au sein de certaines populations, indépendamment de la situation dans laquelle les images sont produites (par exemple, des populations pathologiques). Outre la mise en évidence d’activations régionales, il est également possible de mesurer la connectivité fonctionnelle (y compris au cours du repos) entre différentes aires cérébrales, c’est-à-dire d’étudier comment elles interagissent.

L’imagerie par résonance magnétique fonctionnelle

Avec l’imagerie par résonance magnétique fonctionnelle (IRM fonctionnelle), le signal mesuré est appelé « effet BOLD » (bloodoxygen-level-dependent). Ce signal repose sur les variations de la teneur en oxygène dans les petits vaisseaux (vaisseaux capillaires). En effet, l’augmentation de l’activité des neurones induit une augmentation localisée de l’apport et de la consommation d’oxygène sanguin qui conduit à produire davantage de désoxyhémoglobine, qui est la forme d’hémoglobine débarrassée de l’oxygène qu’elle transportait. Or la désoxyhémoglobine présente des propriétés magnétiques qui la rendent détectable par l’imagerie par résonance magnétique. On déduit alors de l’augmentation du signal BOLD local celle de l’activité des neurones de cette région. Cependant le signal BOLD ne permet pas de déterminer s’il s’agit de populations de neurones inhibiteurs ou excitateurs. Ainsi, le terme d’« activation » ne signifie pas nécessairement que la région en question est à l’origine d’une excitation à distance, car elle peut être responsable, au contraire, d’une inhibition. Autrement dit, suspendre ou activer une région, localement ou à distance, peut produire le même signal.

Références

1 | Raichle M, “Two views of brain function”, Trends Cogn Sci, 2010, 14 :180-90.

2 | Hegger DJ, Ress D, “What does fMRI tell us about neuronal activity ?”, Nature Rev Neurosci, 2002, 3 :142-51.

Peut-on faire ce qu’on veut avec un jeu de données d’IRM fonctionnelle ?

L’un des problèmes de l’imagerie par résonance magnétique fonctionnelle est que les signaux détectés sont de faible intensité et noyés dans un bruit de fond élevé. Il est alors nécessaire de mettre en œuvre des méthodes de traitement de signal sophistiquées, mais qui peuvent conduire à des résultats différents selon les algorithmes utilisés. Ces dernières années, des chercheurs avaient montré à quel point le traitement statistique des données recueillies au cours d’une IRM fonctionnelle pouvait influencer les images finales (celles qui montrent des cerveaux colorés où, par convention, les couleurs chaudes témoignent de l’intensité de l’implication d’une région cérébrale dans une tâche). La démonstration s’appuyait notamment sur le traitement de données brutes par une même équipe appliquant différents filtres d’analyse et parvenant, de la sorte, à obtenir des résultats différents.

Par exemple, en 2016, des chercheurs ont travaillé sur des données recueillies au cours d’IRM fonctionnelles de repos et montré que certains traitements statistiques dits « paramétriques » étaient inappropriés [2]. Ils prétendaient ainsi remettre en cause les résultats obtenus par « 40 000 études en IRM fonctionnelle », ce qui a été relayé dans la presse comme l’invalidation de quinze ans d’études [3]. Dans un correctif [4], les auteurs ont par la suite modifié « 40 000 » en « de nombreuses » (numerous).

Une autre étude avait appliqué pas moins de 6 912 méthodes d’analyse à un seul jeu de données d’IRM fonctionnelle montrant une variabilité importante selon la méthode utilisée dans le poids respectif attribué aux aires cérébrales impliquées [5]. La même étude avait dénombré pas moins de dix étapes successives de traitement statistique permettant d’aboutir aux images finales. Or chacune de ces étapes est susceptible de relever d’une méthodologie propre. Par exemple, le « lissage » consiste à aligner les valeurs individuelles des points (les « voxels », abréviation de volume elements, équivalents tridimensionnels des pixels) sur celles de leurs plus proches voisins. Ce lissage se fait dans l’espace et dans le temps. Il s’agit d’une sorte de moyennage permettant d’homogénéiser les données en réduisant le bruit numérique (fluctuations parasites au moment de la prise d’image). Les risques sont, d’un côté, une perte de sensibilité (faux négatif) liée à la réduction de la variabilité spontanée du signal et, de l’autre, une contamination régionale par une variation locale exagérée (faux positif).

Dans un article publié dans la revue Nature en mai 2020 [1], ce sont, cette fois, soixante-dix équipes internationales indépendantes (dont deux françaises) qui se sont impliquées dans l’analyse et l’interprétation des signaux. Le but était d’apprécier, dans des conditions qualifiées d’« écologiques » (c’est-à-dire dans l’environnement naturel de la recherche, chaque équipe procédant comme bon lui semble), la variabilité dans la production de résultats à partir du traitement statistique d’un seul et même jeu de données d’IRM fonctionnelle. Les équipes devaient tester différentes hypothèses suggérant l’implication de certaines régions dans les tâches réalisées (une prise de décision soumise à un risque, gain ou perte, réalisée par 108 sujets). Or les résultats fournis par les équipes s’avèrent hétérogènes et, de fait, aucune équipe n’a utilisé la même méthode d’analyse, chacune opérant selon ses propres choix. Comme le relève Martin Lindquist, professeur de biostatistiques à l’université Johns Hopkins, dans le commentaire qui accompagne l’article [6], c’est notamment le « lissage » des données qui a le plus contribué à la variabilité des résultats. Sic transit gloria mundi 1 : les « faux positifs » ont-ils eu raison de l’imagerie fonctionnelle ? Pas tout à fait.

Des solutions existent

Comme en conviennent eux-mêmes les auteurs de l’étude de 2020, des solutions existent pour prévenir ce risque, solutions qui passent par deux impératifs. D’une part, la nécessité de partager les données brutes au sein de la communauté scientifique et ce, avant tout traitement. D’autre part, la publication avant même l’expérimentation des méthodes utilisées et des hypothèses testées.

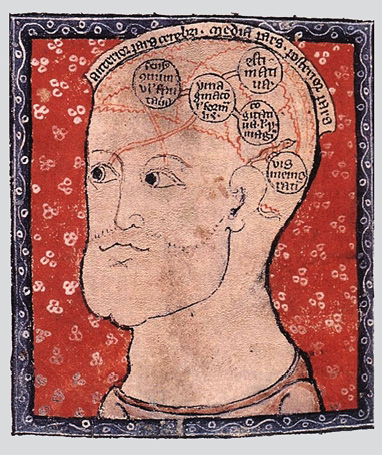

Douter de la validité des images du cerveau, et d’une manière plus générale des connaissances scientifiques portant sur le cerveau et son fonctionnement, a été appelé « neuroscepticisme ». Dans son livre Neuroscepticisme [1], le philosophe Denis Forest passe en revue les critiques qui portent sur les neurosciences et la conception de l’Homme (L’Homme neuronal de Jean-Pierre Changeux) qui en découle. L’une des trois parties de l’ouvrage est entièrement consacrée aux critiques portant sur l’imagerie fonctionnelle et sa nouvelle phrénologie 2 supposée (voir par exemple [2]). Dans cette partie, D. Forest discute précisément les limites méthodologiques et, partant, du crédit que l’on peut apporter aux résultats qui sont produits en s’appuyant sur l’examen des critiques internes à la discipline.

Douter d’une connaissance produite au terme d’un processus contrôlé est propre à la méthode scientifique. Lorsque les auteurs d’un article scientifique abordent la partie « discussion » de leurs résultats, ils doivent commencer par éprouver les limites de leurs affirmations. Ils sont les premiers à douter de la validité de leur méthode, de la portée de leurs résultats. Le processus de « peer reviewing » (évaluation par les pairs) consiste également à exposer le manuscrit à la lecture critique d’experts du même domaine, qui vont exprimer leurs doutes sur la justification de l’étude et le choix de la méthode utilisée. Après publication, le crédit accordé par les lecteurs reposera notamment sur la réputation du journal dans lequel l’article paraît, et le caractère reproductible des résultats.

En somme, le neuroscepticisme est un terme pléonastique. Le scepticisme est ce qui distingue les sciences des pseudo-sciences, il est inhérent à la méthode, et s’exerce à chacune des étapes qui conduisent à la production d’un résultat à partir de données. Il existe une certaine contestation du recours à des résultats issus des neurosciences dans des sujets sociétaux ou politiques, par exemple dans les sciences de l’éducation (voir notre critique de cette contestation [3]), mais cette critique ne peut être qualifiée de « neuroscepticisme » dans la mesure où ce n’est pas la science qui est mise en cause, mais son usage et son interprétation.

L’imagerie fonctionnelle cérébrale produit des résultats discutables et discutés. Elle continue de progresser dans la qualité. La mise à disposition des données brutes permettrait de reproduire (ou d’infirmer) les résultats en modifiant les paramètres d’analyse, ainsi que de conduire des méta-analyses portant sur de plus grands ensembles de données. Ce serait un moyen de parvenir plus rapidement à des résultats faisant l’objet d’un large consensus, en évitant les « coups » individuels. De plus, l’annonce préalable du programme envisagé permettrait d’éviter l’écueil qui consiste à tester différentes méthodes de traitement des images pour conserver (et publier in fine) celle qui a produit les meilleures images, c’est-à-dire celles qui correspondent le mieux aux résultats attendus. La gestion des « faux positifs » fait partie de la démarche scientifique, leur existence n’est pas une fatalité qui devrait conduire à abandonner une voie de la recherche qui a déjà beaucoup contribué à la connaissance du cerveau.

Enfin, le traitement automatique des données permet soit de potentialiser, soit de s’affranchir de l’effet des attentes des chercheurs. Dans le premier cas, l’apprentissage machine est dit supervisé (on renseigne le système sur ce que l’on veut trouver comme résultats en fonction de l’hypothèse scientifique). Les classificateurs, par exemple, peuvent rendre des diagnostics experts sans qu’il soit possible de savoir sur quels critères ils s’appuient. Dans le second cas, l’apprentissage machine est dit non supervisé. Il offre alors la possibilité de générer des représentations indépendantes de tout apriori. L’une des applications les plus prometteuses de l’apprentissage statistique non supervisé consiste à ne plus moyenner les sujets sains de référence dans un atlas unique commun mais au contraire à garder tous les individus sains dans leur variété anatomique et d’imagerie comme base de référence. Cette approche est nommée apprentissage de variété.

de son approche, grâce à la confrontation des expériences, l’intégration des données issues d’autres champs disciplinaires et le partage et la mise en commun des informations. Ainsi va la science.

Références

1 | Forest D, Neuroscepticisme, Les sciences du cerveau sous le scalpel de l’épistémologue, Ithaque, 2014.

2 | , in Vauclair J, Nicolas S (éds.), Localisation cérébrale des fonctions Mentales : de la cranioscopie de Gall à l’IRMf, Solal, 2007, 57-79.

3 | De Smet F, Vercueil L, « À l’école de l’Homme neuronal ? », Esprit n° 447, septembre 2018.

La neuro-imagerie fonctionnelle ne résume pas l’ensemble des neurosciences

Les premiers travaux d’imagerie fonctionnelle, à partir des années 1970 et 1980, ont essentiellement consisté à reproduire des résultats déjà connus : une tâche visuelle devait s’accompagner d’une augmentation de l’activité du cortex occipital où se trouve le cortex visuel, une tâche motrice (bouger les doigts d’une main dans l’IRM) permettait d’activer la zone du mouvement de l’hémisphère opposé, dans la localisation adéquate (l’aire de représentation motrice des doigts), etc. Ce recoupement des résultats entre différentes méthodes constituait un gage de fiabilité de la nouvelle méthode d’exploration, en reproduisant des résultats connus avec une méthode éprouvée.

Avec la diffusion de l’IRM fonctionnelle, les chercheurs se sont enhardis dans l’innovation des paradigmes expérimentaux avec une complexification des tâches et l’impact du traitement statistique des données a explosé. Après s’être assuré que les résultats des tests élémentaires (percevoir par les différents canaux sensoriels, se mouvoir 3, ressentir une émotion) reproduisent les connaissances déjà établies, il était désormais possible de réaliser une cartographie de fonctions plus subtiles et moins accessibles aux autres méthodes des neurosciences. Mais ces dernières continuent néanmoins à apporter leurs contributions et la confrontation des résultats des différentes approches est précisément ce qui peut permettre de progresser. Dans le domaine clinique, l’étude fine des patients porteurs de lésions cérébrales, l’analyse des effets produits par la modulation transitoire du fonctionnement cérébral local (par les techniques de stimulation électrique non invasive ou lors des stimulations corticales in situ), les travaux de neuropsychologie et des sciences cognitives, le recueil des signaux électriques ou magnétiques d’origine cérébrale pendant des tâches spécifiques, constituent des champs de recherche dynamiques qui viennent s’articuler avec l’IRM fonctionnelle. Par ailleurs, l’expérimentation animale constitue également une source majeure d’information sur le fonctionnement du cerveau. La neuro-imagerie fonctionnelle n’est donc qu’une façon parmi d’autres, certes remarquable et spectaculaire, d’étudier le cerveau. Mais ses résultats sont évalués à l’aune des autres méthodes, moins voyantes et moins médiatisées, mais tout aussi contributives. On a tendance à oublier qu’il n’y a pas que les images...

1 | Botvinik-Nezer R et al, “Variability in the analysis of a single neuroimaging dataset by many teams”, Nature, 2020, 582 :84-8.

2 | Eklund A et al., “Cluster failure : Why fMRI interferences for spatial extent have inflated false-positive rates”, PNAS, 2016, 113 :7900-5.

3 | Brown EN, Behrmann M, “Controversy in statistical analysis of functional magnetic resonance imaging data”, PNAS, 2017, 114 :E3368-9.

4 | “Correction for Eklund et al., (2016) ‘Cluster failure : Why fMRI inferences for spatial extent have inflated false-positive rates’”, PNAS, 2016, 113 :E4929.

5 | Carp J, “On the Plurality of (Methodological) Worlds : Estimating the Analytic Flexibility of fMRI Experiments”, Front Neurosci, 2012, 6 :149.

6 | Linquist M, “Neuroimaging results altered by varying analysis pipelines”, Nature, 2020, 582 :36-7.

1 Ainsi passe la gloire du monde.

2 La phrénologie est la discipline pseudo-scientifique inventée à la fin du XVIIIe siècle par Franz Joseph Gall (1758-1828) qui prétendait déceler dans les reliefs crâniens (les « bosses ») le témoignage de facultés spécifiques qu’il affirmait localiser grâce à la palpation.

3 Dans une certaine limite, le mouvement est l’ennemi de la bonne réalisation d’une image. Il faut pouvoir rester immobile pendant l’acquisition des images ou élaborer un modèle fiable d’un mouvement prévisible qui permette de l’intégrer au traitement statistique. Un exemple simple est l’ébranlement périodique lié au battement du cœur, que l’analyse prend en compte pour corriger les déplacements des signaux induits. Mais tous les mouvements ne sont pas prévisibles et modélisables dans la machine.

Thème : Cerveau et cognition

Mots-clés : Neurologie

Publié dans le n° 338 de la revue

Partager cet article

L'auteur

Laurent Vercueil

Laurent Vercueil est médecin hospitalier, neurologue, neurophysiologiste et docteur en neurosciences. Il est membre (…)

Plus d'informationsCerveau et cognition

Y a-t-il une épidémie d’autisme ?

Le 27 octobre 2016

L’héminégligence : quand la moitié de l’« univers » est invisible…

Le 23 novembre 2025

Entretien avec Olivier Dodier

Le 10 juillet 2025

![[Lyon - Mardi 04 novembre 2025 à 20H30] documentaire "Schizophrénie, l'envers de la raison" de Mélodie Proust.](local/cache-gd2/8a/c0dce4f428cba3b530abc5306758c9.png?1762004996)

![[Paris - jeudi 13 novembre 2025 à 19h00] Expériences de mort imminente : mort de la conscience ou conscience de la mort ?](local/cache-gd2/99/79e922ad65041d1318323c7d9fe8c2.png?1759050493)