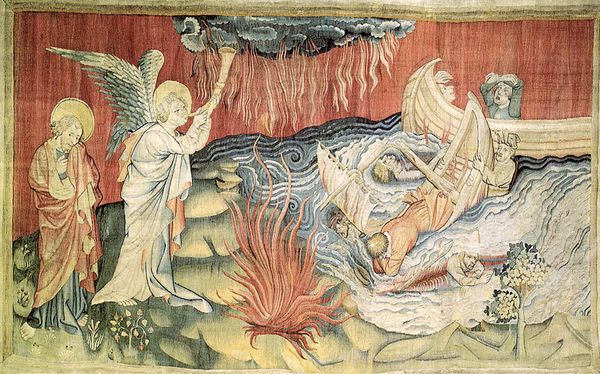

IA génératives, ChatGPT : révolution en cours ou apocalypse annoncée ?

Publié en ligne le 15 juillet 2023 - Intelligence Artificielle -

Dossier coordonné par Ludovic Denoyer et Jean-Paul Krivine

Mis à disposition gratuitement auprès du grand public le 30 novembre 2022, ChatGPT 1, l’agent conversationnel proposé par la société OpenAI, a provoqué un véritable tsunami médiatique. En une semaine, le système comptait déjà un million d’inscrits. Au 1er février 2023, le nombre d’utilisateurs était estimé à cent millions [1]. Depuis, plusieurs grandes entreprises du numérique proposent des services équivalents (comme Bard de Google 2). Pas une journée ne s’écoule sans qu’un article de presse, une émission radio, un reportage télévisé ne discutent des prouesses de ces nouvelles intelligences artificielles (IA) capables de produire un contenu original, que ce soit du texte, des images ou des vidéos. Entre amis ou en famille, difficile d’échapper à une discussion sur ChatGPT, Midjourney, Stable diffusion ou Dalle-E (générateurs d’images). Tantôt on s’alarmera des possibles conséquences délétères : flux accru de désinformation et déstabilisation des démocraties, protection des données personnelles, des droits d’auteurs, impacts sur les emplois, etc. Tantôt, les performances impressionnantes seront mises en avant et les promesses technologiques seront commentées : services rendus, productivité améliorée, métiers facilités ou révolutionnés, accès démocratisé à des outils de créativité, etc. (voir l’article de Jean-Paul Krivine, « IA génératives : une révolution en cours ? »).

Pour appréhender ce qui permet les performances remarquables de ces systèmes, mais aussi comprendre les sources de leurs erreurs, les biais qu’ils reproduisent et, plus généralement, leurs limites, il importe d’analyser la manière dont ils sont mis au point et dont ils fonctionnent. Les agents conversationnels (tels ChatGPT) perfectionnent des techniques qui avaient fait leurs preuves pour le traitement automatique des langues (voir l’article de Laure Soulier et Vincent Guigue, « De l’analyse de la langue aux modèles génératifs »). Les outils de génération d’images reposent également sur des techniques d’apprentissage (fondées sur des réseaux de neurones artificiels), mais adaptées aux spécificités du traitement des images (voir l’article de Ludovic Denoyer et Benjamin Piwowarski, « Les systèmes d’intelligence artificielle pour la génération d’images »).

Si les limites inhérentes à la conception des IA génératives sont plus ou moins identifiées, les risques liés à leur utilisation sont encore mal cernés. Par exemple, la possibilité de créer de faux textes, de fausses images ou de fausses vidéos difficilement identifiables peut nourrir de nouvelles entreprises de désinformation. Mais cela ouvre-t-il pour autant une nouvelle ère, en comparaison des risques déjà identifiés avec les autres systèmes d’IA, et avec le numérique en général ? (voir l’article de Jean-Paul Krivine, « IA génératives : un risque accru de désinformation ? »).

Dans ce contexte, la réglementation à appliquer fait débat. Comment permettre d’exploiter au mieux les opportunités ouvertes tout en se prémunissant au mieux des risques possibles ? Au niveau de l’Union européenne, un projet de réglementation est en discussion (voir l’article de Juliette Sénéchal, [« Les questions juridiques inhérentes aux IA génératives »->art5475]).

Quand il s’agit d’évaluer une nouvelle technologie, l’intelligence artificielle ne fait pas exception : il convient d’examiner chacune des applications au cas par cas, et une application particulière ne valide ni n’invalide la technologie dans l’absolu. L’analyse doit procéder à la fois à l’examen des risques, mais également des bénéfices attendus, sans dramatiser les risques de manière infondée ni, au contraire, se laisser aveugler par des promesses qui ne seraient pas encore solidement étayées.

Enfin, si les discours apocalyptiques prédisant un engrenage fatal pour l’humanité alimentent la controverse médiatique, ils restent assez éloignés de la réalité scientifique, contribuant à masquer les véritables enjeux (voir l’article de Jean-Paul Krivine, « Intelligence artificielle et controverse sur la fin de l’humanité »).

Dans ce dossier de Science et pseudo-sciences, nous proposons à nos lecteurs quelques éléments de compréhension afin qu’ils puissent se faire une opinion éclairée, face à l’abondance d’informations et de déclarations dans les médias. Ce dossier ne prétend bien entendu pas à une quelconque exhaustivité sur un sujet aussi vaste et complexe qui, de plus, progresse très vite.

1 | “ChatGPT sets record for fastest-growing user base – analyst note”, Reuters, 2 février 2023. Sur reuters.com

1 Le nom vient de « chat » qui, en anglais, signifie « conversation » et GPT qui est l’acronyme de « Generative Pretrained Transformer », le nom du type de modèle d’apprentissage automatique utilisé par OpenAI.

2 À ce jour (1erjuin 2023), Google n’a pas encore mis son système Bard à disposition en France.

Publié dans le n° 345 de la revue

Partager cet article

Intelligence Artificielle

L’intelligence artificielle (IA) suscite curiosité, enthousiasme et inquiétude. Elle est présente dans d’innombrables applications, ses prouesses font régulièrement la une des journaux. Dans le même temps, des déclarations médiatisées mettent en garde contre des machines qui pourraient prendre le pouvoir et menacer la place de l’Homme ou, a minima, porter atteinte à certaines de nos libertés. Les performances impressionnantes observées aujourd’hui sont-elles annonciatrices de comportements qui vont vite nous échapper ?

Intelligence artificielle générale : entre fantasmes et réalité

Le 21 septembre 2025

Intelligence artificielle : conscience, autonomie et risques existentiels

Le 20 novembre 2025

La controverse autour de Luc Julia sur l’intelligence artificielle

Le 2 septembre 2025

IA génératives : une révolution en cours ?

Le 17 octobre 2023

![[Quimper - Jeudi 7 mai 2026] Faut-il craindre l'intelligence artificielle ?](local/cache-gd2/aa/44527a70f7a9581abc0ebe20d9c129.jpg?1768404452)