À propos du livre de Thibaut Giraud : La parole aux machines

Intelligence artificielle : conscience, autonomie et risques existentiels

Publié en ligne le 20 novembre 2025 - Intelligence Artificielle -

Pour la première fois dans notre histoire, nous sommes confrontés à des entités non humaines douées de parole et capables de soutenir de longues discussions avec nous. Qui aurait pu imaginer ne serait-ce qu’il y a une dizaine d’années que des machines exhibant de telles performances seraient mises au point aussi vite ? C’est sur ce constat simple et surprenant, mais aussi vertigineux, que s’ouvre La parole aux machines, le dernier livre de Thibaut Giraud [1]. L’auteur est docteur en philosophie avec une spécialisation en logique et philosophie du langage. Il est également créateur de la chaîne YouTube de vulgarisation philosophique intitulée « Monsieur Phi ». Pour lui, il est évident que les philosophes doivent se pencher sur le sujet de l’intelligence artificielle (IA). En effet, dans la réflexion philosophique, le langage et la pensée sont intimement liés et les récents développements de l’intelligence artificielle réinterrogent cette relation. Les machines peuvent-elles penser ? Peuvent-elles avoir une conscience d’elles-mêmes ? En tant que création de l’Homme, peuvent-elles lui échapper ? T. Giraud aborde ces sujets en combinant sa compétence de philosophe avec une très solide connaissance des avancées techniques en intelligence artificielle, en particulier celles relatives aux grands modèles de langage (ou LLM, large language models en anglais) et des robots conversationnels comme ChatGPT 1.

L’histoire récente de l’intelligence artificielle

L’ouvrage est structuré en dix chapitres. Les premiers décrivent d’une façon vivante le renouveau de l’intelligence artificielle dans les années 2010, avec la percée des méthodes d’apprentissage profond 2. Il est question de la victoire en 2015 du logiciel AlphaGo contre le champion du monde de jeu de Go, des premiers pas de l’entreprise OpenAI, des développements des grands modèles de langage au cœur de l’IA générative d’aujourd’hui. T. Giraud rappelle ce constat qui peut paraître troublant : fondamentalement, la tâche réalisée par ces grands modèles de langage, ceux qui nous obligent à revisiter la relation entre pensée et langage, est « simplement » de prédire le prochain mot d’un texte 3. Ils le font sur la base d’un apprentissage effectué sur de gigantesques corpus de données. Les premiers modèles mis au point en 2018 montraient des performances impressionnantes, mais commettaient également de nombreuses erreurs que les utilisateurs ne manquaient pas de rapporter, souvent avec humour. De façon inattendue, le seul accroissement de la taille des modèles a permis de diminuer de façon très importante la fréquence de ces erreurs et les performances de cette approche ont été améliorées d’une manière époustouflante. Ces modèles sont capables aujourd’hui de générer de longs textes au contenu plausible sur tous types de sujets : ils surpassent les humains dans de nombreux tests cognitifs. L’auteur rend alors compte des débats qui animent la communauté scientifique pour déterminer si de tels systèmes font preuve de « compréhension », ou s’il s’agit de simples « moteurs de baratin ». Un chapitre entier est consacré aux « hallucinations », ces contenus générés composés de phrases plausibles et cohérentes, mais qui ne correspondent à aucune réalité (T. Giraud préfère parler à ce propos de « fabulation »). C’est un sujet majeur dans les discussions autour des systèmes d’IA connexionniste, et en particulier des IA génératives.

Avec la mise à disposition du grand public de ChatGPT en novembre 2022, la question a fait brutalement irruption dans l’espace médiatique. ChatGPT est un grand modèle de langage encapsulé dans une architecture plus large permettant d’en faire un système capable de répondre à des requêtes de l’utilisateur sur tout type de sujet. On parle alors de robot conversationnel (chatbot en anglais, où chat signifie « conversation » et bot est le diminutif de « robot »). ChatGPT est le plus célèbre d’entre eux et il tire son nom de la contraction de chat et de GPT, pour Generative Pre-trained Transformer, la technologie de LLM utilisée. L’ouvrage décrit de façon très pédagogique cette encapsulation et le rôle crucial que jouent les différents modules : le system-prompt qui contient les instructions des concepteurs du programme, en amont des requêtes utilisateurs, et les différentes étapes de raffinement (fine-tuning) qui permettent à ce type de système d’interagir avec un utilisateur tout en tentant de respecter un certain nombre de consignes de comportement. On parle alors de l’« alignement du système », c’est-à-dire de sa mise en conformité avec les attentes de ses concepteurs 4. En combinant ces éléments aux demandes de l’utilisateur (le « prompt »), une sorte de personnalité est façonnée que le système simulera dans ses interactions. Ainsi, par défaut, OpenAI assigne à ChatGPT le rôle d’un assistant utile, fournissant des réponses véridiques et ne causant pas de préjudice à l’utilisateur.

De nombreuses améliorations techniques sur cette architecture de base viennent régulièrement augmenter les performances des systèmes. Les innovations se succèdent à une vitesse impressionnante, suscitant de nombreuses controverses sur ce qui pourrait en résulter, avec en particulier les débats sur une intelligence artificielle générale, souvent mal définie, ou au contraire, une limite intrinsèque liée à la nature même de l’approche [2].

Les questions philosophiques

L’auteur revient en détail sur les questions philosophiques soulevées. Ces systèmes font-ils preuve d’une forme d’intelligence ? Peuvent-ils élaborer des concepts abstraits à partir de leurs données d’apprentissage ? Peut-on parler de conscience ? Ou pourra-t-on en parler très bientôt ? Et, ultime interrogation qui cristallise une grande partie de la réflexion : l’intelligence artificielle ainsi créée peut-elle devenir autonome et représenter un danger majeur pour l’humanité ? C’est l’objet des quatre derniers chapitres.

Tout d’abord, la thèse de l’irréductible « supplément d’âme » dont disposerait l’être humain est démontée. Cet argument postule qu’il y aurait quelque chose de spécifique dans l’intelligence humaine, un « je-ne-sais-quoi » singulier, que jamais une machine ne pourrait avoir. T. Giraud discute en détail la manière dont le philosophe Raphaël Enthoven développe cette position. De deux choses l’une, conclut T. Giraud : soit ce supplément d’âme a des effets dans le monde réel, et alors, c’est à ceux qui affirment son existence de préciser le type d’effets observables que l’on pourrait en attendre, et qui pourrait alors faire l’objet d’une expérience. Soit il n’y a pas de tels effets, et alors, cette affirmation « n’est plus qu’un dogme, une affaire de foi ». Alan Turing, pionnier de l’intelligence artificielle, qualifiait dès 1950 ce type d’argument avancé par ceux qui déniaient toute possibilité de créer une machine intelligente, douée de pensées., d’« argument théologique » [3]. T. Giraud parle d’un « dualisme non interactionniste », une thèse quasi-irréfutable sans aucune portée empirique : affirmer que « les machines ne pensent pas » en ce sens-là « ne pose aucune sorte de limite sur leurs capacités présentes ou futures, la pensée n’étant qu’un assaisonnement causalement inerte versé, on ne sait trop pourquoi ni comment, sur certaines machines plutôt que sur d’autres (les machines biologiques plutôt que celles de silicium) ».

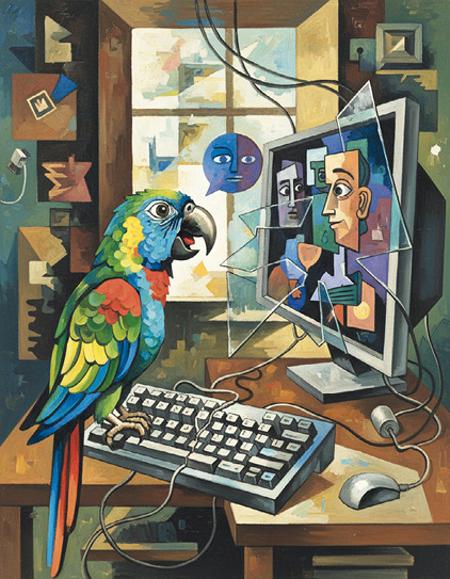

Ensuite, l’auteur réfute la présentation des IA génératives comme des « perroquets stochastiques ». Cette expression popularisée dans un article scientifique de 2021 [4] renvoie à l’idée que les grands modèles de langage ne feraient que répéter avec des variations statistiques ce qu’ils ont synthétisé à partir de leurs données d’entraînement : ils seraient ainsi incapables de comprendre ce qu’ils produisent. En s’appuyant sur les riches débats philosophiques autour du fonctionnalisme, cette approche en philosophie de l’esprit qui considère que les états mentaux sont définis par leur fonction dans un système plutôt que par leur substance physique, l’auteur constate qu’« il n’y a rien de surprenant à ce que la compréhension ou la conscience émerge à partir d’éléments qui eux-mêmes ne comprennent rien et ne sont pas conscients ». À l’aide de nombreuses illustrations des remarquables performances des grands modèles de langage, et en se référant aux dernières innovations technologiques (« chaînes de pensées » par exemple), T. Giraud affirme que les machines sont capables d’abstraction et de conceptualisation leur donnant accès à une certaine compréhension de ce qu’elles traitent. Il conclut que l’on ne peut dès lors pas écarter l’hypothèse qu’elles font preuve d’une certaine autonomie et d’une conscience d’elles-mêmes. Il prend par ailleurs la précaution de définir les termes utilisés tels que « comprendre », « autonomie », « avoir conscience » et de bien préciser l’usage qu’il en fait.

L’ouvrage se termine par une ultime interrogation qui cristallise une grande partie de la réflexion de l’auteur : l’intelligence artificielle ainsi créée peut-elle devenir autonome et représenter un risque existentiel pour l’humanité ? T. Giraud invite à prendre au sérieux le texte de la Déclaration sur le risque de l’IA publiée le 30 mai 2023 affirmant que « l’atténuation du risque d’extinction [de l’humanité] lié à l’IA devrait être une priorité mondiale, au même titre que d’autres risques à l’échelle de la société, tels que les pandémies et les guerres nucléaires » [5]. Plusieurs arguments sont mis en avant : les progrès extraordinaires des IA génératives, la qualité des signataires de l’appel (de grands scientifiques spécialistes de l’IA et des responsables de quelques entreprises majeures dans le domaine) et enfin, le fait qu’un risque existentiel, même avec une probabilité minime, devient d’une importance cruciale.

Un ouvrage passionnant

Ce livre intéressera tout type de lecteurs. Ceux qui sont familiers des technologies d’intelligence artificielle y trouveront un éclairage philosophique étayé et illustré. Le propos est parfois dense, mais toujours très pédagogique. Ceux qui, au contraire, n’ont qu’une connaissance très lointaine des sujets techniques auront accès à une description détaillée et précise qui leur permettra de s’approprier les débats relatifs à certains enjeux majeurs soulevés par ces technologies. L’ouvrage est passionnant même si la lecture est parfois exigeante. L’argumentation est solide, parfois un peu polémique, mais l’auteur s’est plongé dans son sujet et approfondit toutes les questions qu’il traite.

Des objections sur le fond

Toutefois, un certain nombre d’objections peuvent être soulevées concernant les principales conclusions de l’auteur, sans rien enlever à l’intérêt de l’ouvrage. C’est d’ailleurs probablement un des mérites du livre que de permettre de poser le débat d’une façon bien plus claire que ce que l’on constate trop souvent dans l’espace médiatique. Elles concernent la question de la conscience, celle de la compréhension et du rapport au monde et, enfin, la manière d’aborder le problème de l’alignement et du risque existentiel.

La conscience des machines

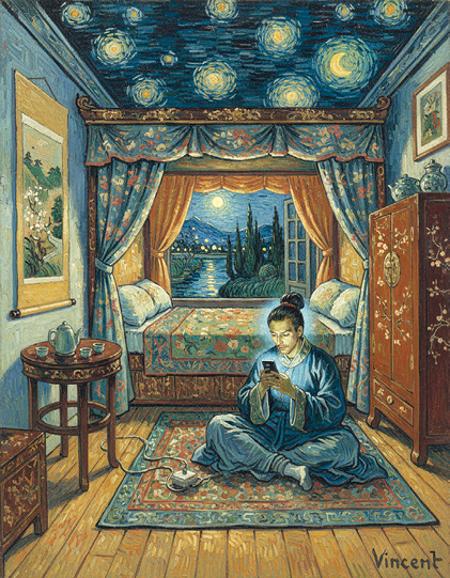

Un chapitre entier est consacré au « problème difficile de la conscience », en référence à la formulation du philosophe David Chalmers. Si, quand on les interroge, les LLM nient avoir toute forme de conscience, c’est, nous affirme T. Giraud, que « les entreprises qui développent les LLM ont fait de la dénégation de conscience une sorte de norme tacite de l’industrie : un bon chatbot doit être serviable, véridique, éviter de causer de préjudice, et ne pas se présenter comme conscient » 5. Et, ajoute-t-il, « si cette norme nous paraît justifiée, c’est parce que nous pensons qu’elle correspond à la réalité : nous sommes convaincus que les LLM, de fait, ne sont pas conscients. Aussi, quitte à leur faire jouer un rôle dans un chatbot, autant que ce soit le rôle d’une IA non consciente ». Mais si on en reste à une approche purement fonctionnaliste, qui ne considère que les interactions avec ces systèmes, rien ne permet d’écarter l’existence d’une forme de conscience et, en tout cas, ceux-ci sont capables « de simuler des comportements conscients de façon convaincante ».

Pour savoir si les LLM sont dotés d’une forme de conscience, l’auteur suggère de se tourner vers les neurosciences et les différentes théories de la conscience qui ont été proposées. Il discute en particulier celle de la « théorie de l’espace de travail global », la plus développée aujourd’hui et portée, par exemple, par les neuroscientifiques français Stanislas Dehaene et Jean-Pierre Changeux [6]. Quelques mécanismes fondamentaux sont identifiés dans ce modèle. En supposant quelques conditions précisément rappelées, « si c’est une théorie de la conscience pertinente, si le fonctionnalisme est correct, et si un système d’intelligence artificielle implémente une structure fonctionnellement similaire », alors, la mise en œuvre de ces mécanismes « serait une raison de penser que ce système a une forme de conscience similaire à la nôtre ». Le propos reste toutefois prudent : ce n’est « peut-être pas une raison suffisante, mais au moins une raison d’augmenter significativement la probabilité que ce soit le cas ». T. Giraud précise bien qu’aujourd’hui, ceux qui avancent cette argumentation, estiment que les architectures actuelles sont encore loin d’implémenter ces mécanismes. Sa conclusion est qu’il convient de rester agnostique avant d’« affirmer avec certitude que les LLM ou les IA en général ne sont pas et ne seront jamais conscients ».

Deux arguments auraient gagné à être développés. Tout d’abord, les modèles neuroscientifiques de la conscience qui sont proposés essaient de décrire les mécanismes à l’œuvre pour des entités dont on suppose a priori qu’elles ont une conscience (l’être humain), sans avoir besoin de définir très précisément ce dont on parle. Ces mécanismes suggérés ne peuvent donc pas être considérés comme étant en eux-mêmes des marqueurs de l’existence d’une conscience (supposée a priori) mais comme des descriptions de la manière dont elle se manifeste. Et donc, le fait que des ordinateurs puissent simuler ou reproduire certains de ces mécanismes ne peut pas être pris comme un argument pour une conscience des machines.

Ensuite, la question de l’incarnation, c’est-à-dire de l’existence à travers un corps matériel qui permet d’agir, de percevoir et d’interagir concrètement avec le monde réel aurait pu être développée. Peut-on vraiment ramener la conscience à une simple structure informationnelle issue de manipulations de symboles ? Il existe une abondante littérature sur ce sujet.

Cette discussion pourrait sembler purement métaphysique, faute d’une définition précise des mots et, surtout, sans une description des conséquences concrètes des réponses apportées. T. Giraud identifie en ce sens deux écueils : « attribuer trop de conscience aux IA […] pourrait causer des préjudices, par exemple en ralentissant ou en empêchant l’adoption de technologies potentiellement bénéfiques ». Mais à l’inverse, souligne-t-il, « ne pas attribuer assez de conscience aux IA […] pourrait aussi être la source de préjudices importants, notamment à leur égard ». Il aurait été intéressant de compléter en soulignant que parler de « conscience » pour les LLM peut conduire à mal poser la question des risques que peuvent poser ces systèmes, et rendre plus difficile leur prise en compte (voir plus loin).

Abstraction et modèles du monde

Les systèmes d’IA générative, dans leurs versions actuelles, ne disposent de quasiment aucun moyen d’apprentissage par interaction avec le monde réel 6. Elles se contentent de compiler les gigantesques corpus de données qui lui sont soumis. Peut-on alors parler de compréhension ? Le lecteur trouvera dans le livre de T. Giraud un passionnant développement sur cette question philosophique qui a accompagnée toute l’histoire de l’IA, avec, entre autres, l’expérience de pensée appelée « chambre chinoise » et imaginée par le philosophe John Searle en 1980 [7].

De manière évidente, les IA génératives construisent des abstractions, ne serait-ce que par le fait qu’elles synthétisent des gigantesques corpus de données en un nombre plus restreints de paramètres internes. Même si le nombre de ces paramètres peut sembler gigantesque (et il l’est, au regard des systèmes mis en place pour les ajuster : GPT-4 contiendrait environ 1750 milliards de paramètres), c’est un nombre bien plus petit que la taille du corpus de données utilisées dans la phase d’apprentissage. Il y a donc des abstractions, mais correspondent-elles à des concepts similaires à ceux élaborés par les humains par interaction avec le monde réel ? Une partie des hallucinations des LLM tendent à montrer que c’est loin d’être toujours le cas. Ces sujets de la « cognition incarnée » et des « modèles du monde » auraient gagné à être plus approfondis (T. Giraud les évoque en particulier en discutant de LLM capables de jouer aux échecs ou à Othello, cas difficilement extrapolables). Ce point est d’autant plus crucial qu’il fait l’objet de très intenses discussions scientifiques [8] [9] ainsi que de travaux spécifiques qui cherchent à sortir du paradigme des LLM (voir par exemple [10]). Il éclaire par ailleurs une partie des débats autour des hallucinations des IA quand elles commettent des erreurs jugées incompréhensibles, fragilisant de nombreux usages.

Le problème de l’alignement

L’alignement des systèmes est au cœur des controverses relatives à une partie des risques que peut présenter l’intelligence artificielle. Comme indiqué plus haut, l’alignement désigne le processus visant à s’assurer qu’un système adopte des comportements conformes aux attentes des concepteurs. L’apprentissage profond à la base des récents développements de l’intelligence artificielle a ceci de particulier qu’il est très difficile de savoir exactement pourquoi un système se comporte d’une certaine manière et pourquoi certains résultats sont produits et pas d’autres. À juste titre, T. Giraud distingue le paradigme de la programmation classique de celui de l’apprentissage profond. Dans le premier, en général, le comportement désiré est programmé explicitement par le développeur. Dans le second, on se contente de donner au système de très nombreux exemples. On pourrait préciser que, dans le cas de la programmation classique, il peut être également complexe, voire impossible, de prouver qu’un système va se comporter comme souhaité, ou même de comprendre simplement pourquoi il arrive à une conclusion ou un résultat 7. Mais on dispose néanmoins d’un programme que l’on peut examiner, modifier et dont on peut tracer précisément le fonctionnement. Dans le cas de l’apprentissage profond, on en est réduit à observer le comportement, et ce dernier ne peut être modifié qu’indirectement, en jouant sur différents paramètres (données d’apprentissage, system-prompt, fine tuning…) sans vraiment être sûr de l’effet qui va en résulter. D’une certaine manière, on « bricole » au mieux les paramètres pour espérer l’alignement recherché. Entre prompt-system, prompt de l’utilisateur et fine-tuning, on peut arriver à un empilement de contraintes parfois contradictoires…

Dès lors, il existe deux manières de décrire le problème auquel l’on fait face. La première, adoptée par T. Giraud et par une partie de la communauté active dans le domaine, consiste à utiliser un langage anthropomorphique. T. Giraud va ainsi écrire que « les LLM sont capables de mensonge et de manipulation », que « le modèle feint l’alignement », que le système a, d’une certaine manière, des intentions et « il sera difficile de garder le contrôle sur des systèmes d’IA de plus en plus autonomes ». Et toute la problématique de l’alignement relève alors d’une sorte de dressage comportemental dont on ne pourra jamais s’assurer de la bonne réalisation, dans lequel on ne pourra jamais exclure de mauvaises intentions, de possibles nouvelles tromperies 8.

Une autre manière de présenter le problème est de le ramener à la mise au point d’un programme difficilement maîtrisable. La « falsification d’alignement des LLM » souvent évoquée peut ainsi être exprimée en d’autres termes que des intentions ou des motivations propres du système. Il s’agira alors d’une conséquence logique, mais difficilement explicitable, de la superposition de consignes et de données d’apprentissage potentiellement contradictoires. En adoptant ce point de vue, n’éviterait-on pas une sorte de « bavardage » anthropocentré sur la manière dont les LLM procèdent pour essayer de résoudre ces contradictions, invoquant velléité d’autonomie, motivations, mensonges ou tricheries ? La gestion du risque se ramène alors à une question plus facile à appréhender et permettant un traitement plus opérationnel.

Dans ce contexte, quand on s’intéresse aux programmes d’IA, s’agissant de programmes informatiques en général moins prédictibles, une attention particulière doit être accordée à la balance risques – bénéfices dans les usages afin d’éviter toute dissémination inconsidérée. De nombreux modules d’IA sont déjà embarqués dans des applications réelles et ont suivi ce genre d’analyse. Même si ce ne sont en général pas des IA génératives, ce sont des systèmes potentiellement sujets à des hallucinations, C’est par exemple le cas des systèmes de freinage d’urgence (Automatic Emergency Braking) rendus obligatoires dans les véhicules commercialisés en Europe depuis 2024 qui, pour la plupart, contiennent des modules d’IA.

Le « problème de l’alignement » n’apparaît ainsi pas comme fondamentalement nouveau, mais comme une variation du problème classique de la spécification et de la vérification en informatique, particulièrement pour les systèmes apprenants. La différence porte sur la manière spécifique dont il convient de l’aborder (apprentissage statistique versus programmation explicite). La connotation anthropomorphique des termes n’est-elle alors pas de nature à obscurcir le débat (voir par exemple [11]) ?

Le risque existentiel

C’est l’objet de la conclusion de l’ouvrage qui s’ouvre sur le rappel de la Déclaration sur le risque de l’IA publiée le 30 mai 2023 et évoqué plus haut. L’auteur de La parole aux machines fustige « ceux qui affirment avec assurance qu’il n’y a rien à craindre de ces systèmes et qu’en dehors de ce qu’ils prévoient tout n’est que science-fiction, ceux-là peuvent donner l’impression de faire preuve d’un bon sens modéré et réaliste, quand en réalité ils expriment une certitude bien excessive quant à ce que les prochaines années nous réservent : ce sont eux qui se comportent en prophètes, arc-boutés sur le dogme du tout ira bien ».

Tout d’abord, les arguments de ceux qui n’adhèrent pas aux scénarios de risque existentiel et qui les qualifient de scénarios de science-fiction ne consistent en général pas à dire qu’il n’y aurait aucun risque et qu’il n’y a rien à craindre de ces systèmes. Soulignons au passage que parmi eux, il y a des scientifiques du même niveau que les signataires de l’appel.

Le propos aurait ensuite gagné à précisément décrire et commenter les scénarios de risques existentiels envisagés. L’ouvrage se contente dans une note de renvoyer aux analyses de Yoshua Bengio [12], pionnier de l’intelligence artificielle récompensé en 2018 par le Prix Turing. La question clé est bien entendu celle de l’action sur le monde réel. Que des programmes d’IA puissent dépasser les humains sur de nombreuses capacités cognitives est une évidence. Qu’ils puissent être utilisés à des fins malveillantes est déjà une réalité (désinformation, cyberattaques, etc.). C’est d’ailleurs une constante de toutes les technologies : elles peuvent être utilisées de façon malveillante et il convient alors de s’interroger sur celles qui deviennent à la fois plus puissantes et plus facilement accessibles. Enfin, que ces programmes puissent ne pas se comporter comme prévu ne fait pas non plus de doute : c’est la question de l’alignement évoquée plus haut. Pour autant, le risque existentiel se cristallise quand ces systèmes agissent sur le monde réel. Selon Y. Bengio, cela peut se produire de deux manières.

La première est l’intégration directe dans des systèmes physiques, quand ils s’insèrent dans la chaîne de causalité de ces systèmes, par exemple ceux liés à des armes ou des infrastructures critiques. En reconnaissant le risque de ces configurations et la nécessité de s’en prémunir, on peut légitimement s’interroger sur la responsabilité attribuée à la seule intelligence artificielle. Que dirions-nous d’une arme dotée d’un système de déclenchement mal maîtrisé, quelle qu’en soit la technologie ? La responsabilité de l’intégration d’un tel programme n’incombe-t-elle pas d’abord à l’Homme ? Cette dernière question se pose d’ailleurs pour tous les systèmes critiques existant aujourd’hui : armement, gestion de grandes installations industrielles, infrastructures, pilotage d’appareils autonomes ou d’avions, etc. Les conséquences peuvent constituer un risque majeur, voire existentiel. Mais est-il légitime d’imputer ce risque final à chacune des technologies intégrées dans ces systèmes ?

La seconde modalité d’expression d’un risque existentiel, toujours selon Y. Bengio, est l’influence délétère que peuvent avoir les systèmes d’IA sur des humains en capacité d’agir. Les capacités persuasives de ces systèmes, l’outil de désinformation qu’ils peuvent constituer, et plus généralement la mise à disposition de leurs capacités cognitives au service de personnes mal intentionnées est bien réelle. Mais ce risque est-il véritablement spécifique à l’IA ? La désinformation, la manipulation psychologique et l’amplification des capacités d’individus malveillants ont toujours existé, que ce soit via la propagande, des médias de masse ou d’Internet. La désinformation pour être efficace doit rencontrer des attentes, épouser des biais cognitifs et s’appuyer sur des contextes sociaux favorables chez les personnes visées. Discuter dans quelle mesure l’IA change la donne aurait été intéressant.

En tout état de cause, il n’est pas prouvé que naturaliser le discours des machines et présenter le sujet en termes de systèmes d’IA ayant leurs objectifs propres, dotés d’intentions et de motivations, possiblement malveillants ou menteurs, aide à bien exposer la nature des risques, pourtant réels, et surtout, à s’en prémunir.

Un des intérêts majeurs de La parole aux machines est de contribuer à ces débats d’une façon riche et argumentée.

1| Giraud T (Monsieur Phi), La parole aux machines – Philosophie des grands modèles de langage, Grasset, 2025, 480 pages, 25 €.

2| Krivine JP, « Intelligence artificielle générale : entre fantasmes et réalité », sur le site www.afis.org, 21 septembre 2025.

3| Turing A, “Computing Machinery and Intelligence”, Mind, 1950.

4| Bender EM et al., “On the Dangers of Stochastic Parrots : Can Language Models Be Too Big ?”, dans Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency (FAccT ’21), 2021.

5| “Statement on AI Risk”, Center for AI safety, 2023.

6| Mashour GA et al., “Conscious Processing and the Global Neuronal Workspace Hypothesis”, Neuron, Mar 4 ;105(5):776-798, 2020.

7| Searle J, Minds, Brains, and Programs. Behavioral and Brain Sciences, 3(3), 417-457, 1980.

8| Barrett L et Stout D, “Minds in movement : embodied cognition in the age of artificial intelligence”, Philos Trans R Soc Lond B Biol Sci., Oct 7 ;379(1911):20230144, 2024

9| Marcus G, “Generative AI’s crippling and widespread failure to induce robust models of the world”, sur garymarcus.substack.com, 18 juin 2025.

10| “I-JEPA : The first AI model based on Yann LeCun’s vision for more human-like AI”, le blog de Yann LeCun sur le site ai.meta.com, 13 juin 2023.

11| Kambhampa S, “Stop anthropomorphizing intermediate tokens as reasoning/thinking traces !”, prepublication sur arXiv, 25 mai 2025.

12| Bengio Y, « Comment des IA nocives pourraient apparaître », sur yoshuabengio.org , le site de Yoshua Bengio, 30 mai 2023.

1 ChatGPT est développé par l’entreprise OpenAI, mais il existe de nombreux concurrents : LeChat (Mistral), Claude (Anthropic), DeepSeek (du nom de la société chinoise qui l’a mis au point) ou Gemini (Google).

2 Par la suite, nous utiliserons le terme « intelligence artificielle » (ou l’acronyme IA) pour désigner cette seule IA dite « connexionniste », laissant de côté l’IA dite « symbolique » qui a marqué les décennies précédentes.

3 En réalité, ces modèles prédisent le prochain « token » et non pas le prochain mot. Un token est une petite unité de texte, souvent plus courte qu’un mot (sans pour autant être nécessairement un phonème ou une syllabe). Par exemple, l’expression « L’intelligence artificielle » pourrait se décomposer en cinq token : « L’ », « int », « elligence », « art » et « ificielle ». Le choix des token dépend des modèles.

4 On parle bien ici des techniques d’alignement, pas du choix des valeurs sur lesquelles les concepteurs souhaitent aligner le système qu’ils mettent au point, ce qui est un autre problème.

5 T. Giraud nuance cette affirmation au regard des dernières spécifications d’OpenAI, moins catégoriques en la matière. Et il est possible que cette position évolue si la réflexion dans la société sur ce sujet évolue.

6 Même lorsqu’ils peuvent agir sur le monde réel via des interfaces, les systèmes dits « agentiques » restent essentiellement entraînés à partir de corpus de données massifs. L’apprentissage par renforcement parfois utilisé dans les IA génératives concerne surtout le fine-tuning pour aligner le comportement sur les objectifs des concepteurs. Dans d’autres systèmes où l’apprentissage par renforcement est mis en œuvre, comme les véhicules autonomes, il se fait encore principalement dans des environnements simulés, l’expérience réelle servant surtout à valider ou ajuster les modèles.

7 Par exemple, dans le paradigme de la programmation par contraintes, on décrit un ensemble de conditions à respecter et le système en déduit une solution optimale. Il n’est alors pas toujours facile de remonter de cette solution aux contraintes exactes qui l’ont produite, car plusieurs contraintes peuvent interagir de manière complexe et peu traçable.

8 Le terme « alignement » n’est pas un problème en soi quand il sert à désigner un objet de recherche et la communauté scientifique qui s’y intéresse.

Publié dans le n° 355 de la revue

Partager cet article

L'auteur

Jean-Paul Krivine

Rédacteur en chef de la revue Science et pseudo-sciences (depuis 2001). Président de l’Afis en 2019 et 2020. (…)

Plus d'informationsIntelligence Artificielle

L’intelligence artificielle (IA) suscite curiosité, enthousiasme et inquiétude. Elle est présente dans d’innombrables applications, ses prouesses font régulièrement la une des journaux. Dans le même temps, des déclarations médiatisées mettent en garde contre des machines qui pourraient prendre le pouvoir et menacer la place de l’Homme ou, a minima, porter atteinte à certaines de nos libertés. Les performances impressionnantes observées aujourd’hui sont-elles annonciatrices de comportements qui vont vite nous échapper ?

Intelligence artificielle générale : entre fantasmes et réalité

Le 21 septembre 2025

Intelligence artificielle : conscience, autonomie et risques existentiels

Le 20 novembre 2025

La controverse autour de Luc Julia sur l’intelligence artificielle

Le 2 septembre 2025

IA génératives : une révolution en cours ?

Le 17 octobre 2023

![[Quimper - Jeudi 7 mai 2026] Faut-il craindre l'intelligence artificielle ?](local/cache-gd2/aa/44527a70f7a9581abc0ebe20d9c129.jpg?1768404452)