Intelligence artificielle : le présent éclairé par l’histoire

Publié en ligne le 16 août 2020 - Intelligence Artificielle -

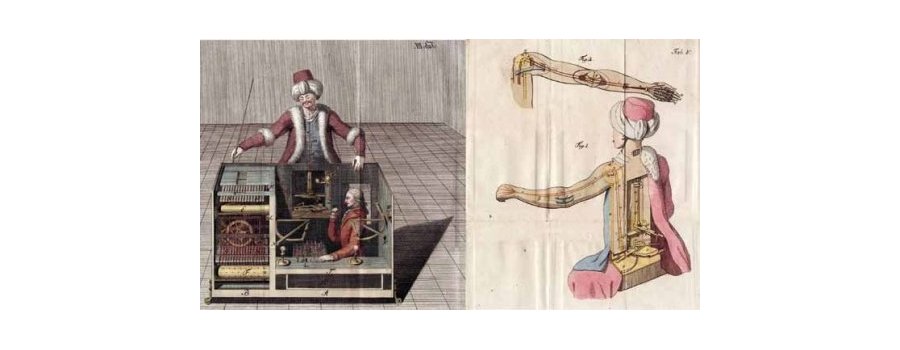

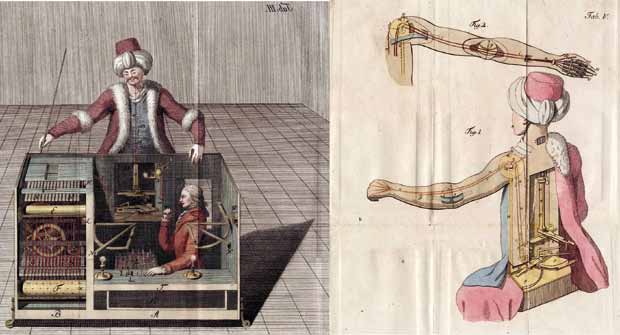

Concevoir des machines intelligentes est un très vieux rêve de l’humanité. Dès l’Antiquité, ingénieurs et mathématiciens tentèrent de mettre au point des automates visant à imiter certains comportements naturels. Ainsi, selon l’historienne Marylène Lebrère, les automates d’Héron d’Alexandrie (Ier siècle de notre ère) sont réalisés de telle sorte que « les mouvements des personnages, des animaux ou les sons qu’ils émettent doivent être aussi vrais que possible, de façon à susciter la surprise et l’émotion chez les fidèles » [1]. Les réalisations de Jacques Vaucanson (1709-1782) s’inscrivent dans la même volonté de « non pas représenter de l’extérieur ce que font les vivants, mais bien, autant que cela était possible, simuler les processus naturels par lesquels ils accomplissent certaines de leurs actions » [2]. Les capacités intellectuelles de l’Homme font aussi l’objet de nombreuses tentatives d’automatisation. L’arithmétique en particulier suscite un fort intérêt de par les services que pourraient rendre des machines capables de calculer. La pascaline, mise au point par Blaise Pascal (1623-1662), est capable d’effectuer des additions et des soustractions. La machine analytique de Babbage (1791-1871), première machine permettant une sorte de programmation 1, permet d’effectuer automatiquement une suite d’opérations. Mais d’autres fonctions sont visées. Euphonia, l’automate parlant mis au point par Joseph Faber (1800-1850) était capable de prononcer des mots et de reproduire une voix humaine. Le Turc mécanique conçu par Johann Wolfgang von Kempelen (1734-1804) se présentait comme un automate capable de jouer aux échecs. Durant plusieurs décennies, il fit le tour des grandes villes d’Europe et des États-Unis et battit, lors de démonstrations publiques, la plupart de ses adversaires, dont l’empereur Napoléon Bonaparte. L’écrivain Edgar Allan Poe décrivant la controverse de l’époque entre les partisans d’une explication mécanique et ceux convaincus qu’il s’agissait d’une illusion bien mise en scène avec un opérateur humain caché à l’intérieur du dispositif (ce qui était le cas) donne dix-sept arguments pour cette dernière hypothèse, dont celui-ci : « L’Automate ne gagne pas invariablement. Si la machine était une pure machine, il n’en serait pas ainsi, elle devrait toujours gagner » [3].

L’intelligence artificielle (IA) est véritablement née avec l’informatique : en présentant en 1936 un modèle théorique décrivant ce qu’allaient être les ordinateurs [4], le mathématicien Alan Turing (1912-1954) proposait en même temps un support conceptuel possible pour une intelligence générale (son modèle est appelé depuis « machine de Turing »). Mais le terme d’intelligence artificielle n’est apparu qu’en 1956 lors d’un séminaire organisé à Dartmouth aux États-Unis, qui partait de la conjecture selon laquelle 2 « chaque aspect de l’apprentissage ou toute autre caractéristique de l’intelligence peut en principe être décrit de façon si précise qu’une machine peut être conçue pour le simuler » [5]. Dès les premiers pas de la discipline, les discussions sont âpres : les machines peuvent-elles être intelligentes ? Alan Turing en était convaincu et affirmait : « La question “Les machines peuvent-elles penser ?” est à mon avis trop dénuée de sens pour être débattue. Je suis néanmoins convaincu qu’à la fin de ce siècle, l’usage des mots et l’opinion générale des personnes instruites auront tellement changé que l’on pourra parler de machines pensantes sans risquer d’être contredit » [6].

Il fonde sa conviction sur des considérations théoriques : la machine de Turing fournit un cadre très puissant permettant de rendre compte de tout ce qui est « calculable », y compris les mécanismes de raisonnement humain. Mais peut-on ramener l’intelligence à un tel processus ?

Qu’est-ce que l’intelligence ?

Sans définir précisément ce qu’est l’intelligence, affirmer que jamais une machine ne pourra être intelligente est vide de sens. L’intelligence humaine sert souvent de référence, mais elle est elle-même difficile à définir. Alan Turing avait contourné le problème en mettant en avant un procédé original pour déterminer si une machine peut être qualifiée d’intelligente sans avoir à définir le terme. Il proposait de comparer « en aveugle » une machine et un être humain : si un observateur extérieur n’arrive pas discerner qui est la machine et qui est l’être humain, alors la machine peut être considérée comme intelligente (voir l’encadré « Le test de Turing »). Cette approche est bien entendu restrictive, la référence pour déterminer ce qu’est l’intelligence étant ici l’être humain qu’il s’agit d’imiter 3 (pourquoi l’intelligence ne serait-elle que ce que réalise un être humain ?). Mais elle a l’avantage de permettre une évaluation qui met de côté la manière dont la performance est réalisée et se contente de la constatation du résultat (en gardant à l’esprit que même la constatation du résultat peut ne rien prouver sur l’intelligence réellement mise en œuvre – voir les discussions autour de « la chambre chinoise », expérience de pensée proposée par le philosophe John Searle [7]).

Plus d’un demi-siècle de controverses, parfois vives, n’ont pas épuisé le sujet. Et dès 1950, Alan Turing contestait des arguments encore avancés aujourd’hui : la pensée serait une fonction réservée à l’âme des seuls êtres humains ; les émotions, le ressenti et la conscience de soi seraient inaccessibles aux machines ; il existerait des limitations théoriques à ce que peut faire une machine de Turing ; les machines ne pourraient faire « que ce qu’on leur a appris », etc. [6]

« Alan Turing voulait éviter de discuter de la nature de l’intelligence et, plutôt que d’en rechercher une définition, proposait de considérer qu’on aura réussi à mettre au point des machines intelligentes lorsque leur conversation sera indiscernable de celle des humains.

Pour tester cette indiscernabilité, il suggérait de faire dialoguer par écrit avec la machine une série de juges qui ne sauraient pas s’ils mènent leurs échanges avec une machine tentant de se faire passer pour un humain ou avec un humain véritable. Lorsque les juges ne pourront plus faire mieux que répondre au hasard pour indiquer qu’ils ont eu affaire à un être humain ou une machine, le test sera réussi. Concrètement, faire passer le test de Turing à un système informatique S consiste à réunir un grand nombre de juges, à les faire dialoguer aussi longtemps qu’ils le souhaitent avec des interlocuteurs choisis pour être une fois sur deux un humain, et une fois sur deux le système S ; les experts indiquent, quand ils le souhaitent, s’ils pensent avoir échangé avec un humain ou une machine. Si l’ensemble des experts ne fait pas mieux que le hasard, donc se trompe dans 50 % des cas ou plus, alors le système S a réussi le test de Turing.

Turing, optimiste, pronostiqua qu’on obtiendrait une réussite partielle au test en l’an 2000, les experts dialoguant cinq minutes et prenant la machine pour un humain dans 30 % des cas au moins. Turing avait, en gros, vu juste : depuis quelques années, la version partielle du test a été réussie, sans qu’on puisse prévoir quand sera réussi le test complet, sur lequel Turing restait muet.

Le test partiel a par exemple été réussi le 6 septembre 2011 à Guwahati, en Inde, par le programme Cleverbot créé par l’informaticien britannique Rollo Carpenter. Trente juges dialoguèrent pendant quatre minutes avec un interlocuteur inconnu qui était dans la moitié des cas un humain et dans l’autre moitié des cas le programme Cleverbot. Les juges et les membres de l’assistance (1 334 votes] ont considéré le programme comme humain dans 59,3 % des cas. Notons que les humains ne furent considérés comme tels que par 63,3 % des votes […].

Le test complet de Turing n’a pas été réussi, et il n’est sans doute pas près de l’être. Il n’est d’ailleurs pas certain que les tests partiels fassent avancer vers la réussite au test complet. En effet, les méthodes utilisées pour tromper brièvement les juges sont fondées sur le stockage d’une multitude de réponses préenregistrées (correspondant à des questions qu’on sait que les juges posent) associées à quelques systèmes d’analyse grammaticale pour formuler des phrases reprenant les termes des questions des juges et donnant l’illusion d’une certaine compréhension. »

Source

Delahaye JP, « Une seule intelligence ? », Pour la Science, décembre 2014.

IA forte et IA faible

Le projet scientifique d’une « IA forte » se fixe l’objectif de concevoir une intelligence générale, polyvalente, qui ait une réelle conscience de soi et de ses raisonnements et puisse éprouver des sentiments. Cela peut être un projet scientifique fécond permettant de soulever des questions intéressantes, mais de façon pratique, tous les systèmes existants aujourd’hui sont considérés comme des « IA faibles », c’est-à-dire des intelligences spécialisées (jouer aux échecs, piloter un avion, reconnaître un visage sur une photo, etc.).

Si la discipline scientifique qu’est l’intelligence artificielle s’est constituée sur un programme d’IA faible en postulant que le raisonnement intelligent pouvait se décomposer en briques élémentaires simulables sur ordinateur, l’idée sous-jacente de bon nombre de chercheurs était que l’assemblage de ces briques permettrait de mettre au point des intelligences de plus en plus performantes et que la somme des IA faibles pourrait un jour déboucher sur une IA forte. Cette question se retrouve de nouveau au centre d’une partie des controverses actuellement médiatisées.

Les premiers pas de l’IA ont été marqués par un enthousiasme excessif qui a sans doute contribué aux désillusions qui ont suivi, et à une première traversée du désert. Herbert Simon, l’un des pionniers de la discipline (et futur Prix Nobel d’économie) déclarait ainsi en 1958 que, dans les dix années à venir, une machine serait championne du monde d’échecs, une autre découvrirait ou démontrerait un nouveau théorème de mathématique important, une autre encore serait capable de composer de la musique dotée d’une indéniable valeur esthétique et, enfin, que la plupart des thèses émises en psychologie revêtiraient la forme de programmes d’ordinateur ou de commentaires qualitatifs sur les traits saillants de programmes d’ordinateur [8]. En 1965, il renchérissait en affirmant que, dans les vingt ans à venir, « les machines seraient capable de faire tout ce que font les Hommes » [9].

© Rama, Cc-by-sa-2.0-fr

« Tant qu’une machine n’aura pas écrit un sonnet ou composé un concerto à partir de ses pensées et de ses émotions, et non par un simple enchaînement de symboles, nous ne pourrons pas dire que la machine égale l’Homme. Il faut non seulement que la machine ait créé l’œuvre, mais aussi en ait conscience. »

Alan Turing contestait cette affirmation en soulignant qu’avec cette vision, la seule façon de vérifier que la machine pense, c’est d’être soi-même la machine pour décrire les sentiments réellement ressentis. Ce qu’en dirait la machine elle-même ne serait pas suffisant. Mais alors, ajoutait-il, on peut dire la même chose d’un être humain : à moins d’être cette personne, on ne peut pas savoir ce qu’il y a vraiment dans son cerveau.

Source

Turing A, “Computing Machinery and Intelligence”, Mind, 1950, 59 :433-460.

1950-1970 : des objectifs ambitieux mais des résultats décevants

Les objectifs alors assignés par les pionniers de la discipline sont ambitieux : traduction automatique, reconnaissance des formes ou encore résolveurs généraux de problèmes. Mais les résultats obtenus sont loin des prophéties médiatisées et le contrecoup se fait douloureusement sentir. Ainsi en 1966, l’armée américaine qui avait largement financé les travaux en traduction automatique (en pleine période de guerre froide où cette compétence était précieuse) va-t-elle brutalement couper les fonds [10]. Pourtant, même si les programmes ne savent résoudre que des petits « problèmes jouets », cette première période a permis de développer des outils de base qui connaîtront de grands développements : les langages structurés, les grammaires génératives, le « perceptron », ancêtre des réseaux de neurones qui sont aujourd’hui à la base de l’apprentissage profond (ou deep learning), etc. Les chercheurs se sont rendu compte que leurs réalisations, pour pouvoir s’appliquer à des problèmes de la vie réelle, devaient intégrer une très grande quantité de connaissances (spécifiques au domaine traité ou de sens commun).

1970-1990 : des résultats prometteurs, mais complexes à obtenir

Pour résoudre les problèmes auxquels elle s’attaque, l’IA doit donc être dotée de nombreuses connaissances. Le terme « connaissance » est tout aussi difficile à définir que celui d’intelligence. On peut cependant, ici, le spécifier comme la capacité à utiliser des informations à bon escient et à comprendre la sémantique et le contexte des concepts et objets manipulés. Paradoxalement, les connaissances expertes vont s’avérer plus facile à prendre en compte que les connaissances de sens commun. En effet, ces dernières supposent la compréhension d’un contexte très mal défini, d’un monde ouvert où l’expérience compte beaucoup, à l’inverse de connaissances spécifiques particulières à un domaine précis et utilisant souvent un vocabulaire bien circonscrit.

C’est ainsi que les premiers « systèmes experts » vont voir le jour. Il s’agit de systèmes informatiques qui doivent résoudre des problèmes très précis en utilisant une somme de connaissances pointues (souvent obtenues auprès d’experts du domaine) et des « heuristiques » bien adaptées. La principale difficulté consiste alors à acquérir ces connaissances, à les formaliser dans un programme informatique et à les mettre en œuvre de façon appropriée. Des résultats impressionnants sont obtenus. Ainsi, Prospector (1982), un système expert dédié à la prospection minière, découvre un gisement de molybdène. L’article de la revue Science qui présente les résultats [11] précise que le système « a identifié avec précision la présence d’une minéralisation significative, non contrôlée auparavant, dans un système préalablement connu [et] que ce résultat a été obtenu parce que la programmation de Prospector reflète judicieusement une partie limitée, mais appropriée, du savoir et de l’expérience d’un expert réputé du porphyry molybdenum ».

Mycin est un système expert spécialisé dans le diagnostic de maladies infectieuses du sang (méningites) et la proposition de thérapies associées. Il a été évalué de façon rigoureuse (une sorte de « double aveugle ») et les résultats ontété publiés en 1979 dans la prestigieuse revue médicale JAMA [12]. Huit experts du domaine ont comparé le choix des antimicrobiens proposés par le système sur dix cas cliniques qui lui ont été soumis avec les choix qu’auraient fait neuf prescripteurs humains (médecins hospitaliers, internes, etc.) sur ces mêmes patients. Et c’est le système expert qui a obtenu les meilleurs résultats. Comme le note l’article rendant compte de l’expérience, « le système n’a jamais manqué de traiter un agent pathogène présent tout en démontrant son efficacité à minimiser le nombre d’antimicrobiens prescrits ».

L’enthousiasme suscité par ces performances va s’étendre bien au-delà des cercles académiques. On assiste à un véritable engouement industriel : tous les grands groupes créent des équipes dédiées à l’intelligence artificielle et se lancent dans de grands projets. De très nombreux domaines d’application sont explorés. Mais, une nouvelle fois, les désillusions ne vont pas tarder à apparaître : concevoir un système expert est particulièrement long et délicat. Si des résultats positifs sont souvent obtenus, ils sont loin de permettre la rentabilisation de l’investissement. De plus, les systèmes conçus s’avèrent souvent difficile à maintenir et à faire évoluer. Les ardeurs ont été refroidies et, progressivement, le terme d’intelligence artificielle disparaît du monde des entreprises, et même de la plupart des universités. Pourtant, de façon discrète, de nombreuses techniques mises au point dans cette période sédimentent et se retrouvent intégrées dans l’informatique « normale » (par exemple, les langages orientés objet, sortes de langages de programmation structurés, ou encore la programmation par contrainte qui permet de résoudre des problèmes complexes d’optimisation). Et des applications opérationnelles voient le jour, sans forcément être qualifiées d’« intelligence artificielle ».

Durant cette période, l’IA dite « symbolique » (car manipulant des connaissances sous formes de symboles et de propositions logiques) éclipse l’approche dite « connexionniste », celles des réseaux de neurones issue du Perceptron des années 1950. En effet, non seulement elle permettait d’obtenir des résultats impressionnants, mais elle était également capable d’expliquer son raisonnement et de justifier ses conclusions là où les réseaux de neurones apparaissaient comme des sortes de boîtes noires 4. Paradoxalement, ce sont les réseaux de neurones qui vont être à la base du renouveau de l’IA que l’on connaît aujourd’hui.

Les années 2000 : l’apprentissage profond et l’explosion de l’IA

L’IA semble maintenant omniprésente : dans nos téléphones portables, dans les assistants vocaux, dans les systèmes de reconnaissance d’images ou dans les systèmes d’aide à la conduite (et peut-être dans de futurs véhicules autonomes).

Elle réussit à battre le champion du monde d’échec, et même celui du jeu de go, réputé bien plus complexe. La traduction automatique sur Internet est d’usage courant. Cette IA fait tantôt peur et tantôt rêver. Derrière ses performances que chacun peut constater et expérimenter se trouve une technologie particulière : celle de l’apprentissage profond (deep learning) à base de réseaux de neurones.

Trois évolutions majeures ont permis cette véritable révolution technologique : des ordinateurs de plus en plus puissants, une quantité phénoménale de données disponibles (le « big data ») et la mise au point d’algorithmes d’apprentissage de plus en plus performants.

D’innombrables questions sont posées : quelle est la responsabilité de machines qui deviennent de plus en plus autonomes (incluant une éventuelle responsabilité juridique) ou encore quelle sera l’acceptabilité de systèmes qui prennent des décisions importantes nous concernant et qui, souvent, ne peuvent pas expliquer leurs choix ? Certains prédisent même une situation où la place de l’Homme serait menacée par des machines pouvant devenir hors de contrôle.

« Les tâches relevant de l’IA sont parfois très simples pour les humains, comme par exemple reconnaître et localiser les objets dans une image, planifier les mouvements d’un robot pour attraper un objet, ou conduire une voiture. Elles requièrent parfois de la planification complexe, comme par exemple pour jouer aux échecs ou au go. Les tâches les plus compliquées requièrent beaucoup de connaissances et de sens commun, par exemple pour traduire un texte ou conduire un dialogue […]. Mais ce qui manque principalement aux machines, c’est le sens commun, et la capacité à l’intelligence générale qui permet d’acquérir de nouvelles compétences, quel qu’en soit le domaine. Mon opinion, qui n’est partagée que par certains de mes collègues, est que l’acquisition du sens commun passe par l’apprentissage non supervisé […].

C’est grâce à l’apprentissage non supervisé que nous pouvons interpréter une phrase simple comme “Jean prend son portable et sort de la pièce”. On peut inférer que Jean et son portable ne sont plus dans la pièce, que le portable en question est un téléphone, que Jean s’est levé, qu’il a étendu sa main pour attraper son portable, qu’il a marché vers la porte. Il n’a pas volé, il n’est pas passé à travers le mur. Nous pouvons faire cette inférence, car nous savons comment le monde fonctionne. C’est le sens commun […].

Tant que le problème de l’apprentissage non supervisé ne sera pas résolu, nous n’aurons pas de machine vraiment intelligente. C’est une question fondamentale scientifique et mathématique, pas une question de technologie. Résoudre ce problème pourra prendre de nombreuses années ou plusieurs décennies. En vérité, nous n’en savons rien. »

Source

Lecun Y, « Qu’est-ce que l’intelligence artificielle ? », conférence au Collège de France, 2015. Sur college-de-france.fr

Mais la réalité n’est pas celle d’une prochaine prise du pouvoir par les machines. Malgré ses performances, l’apprentissage profond est loin de pouvoir résoudre tous les défis soulevés par la mise au point d’une intelligence artificielle. Certains des problèmes identifiés au tout début de l’histoire de l’IA restent entiers. C’est en particulier le cas des connaissances de sens commun qui font toujours cruellement défaut aux systèmes d’IA pour appréhender des situations pourtant simples pour un être humain. Il n’en reste pas moins important de mesurer les conséquences possibles d’une informatique de plus en plus puissante, au-delà du terme galvaudé d’intelligence artificielle. Mais il importe d’aborder ces questions sur la base de la réalité scientifique et l’histoire de l’IA nous rappelle qu’il faut rester prudent quant aux déclarations révolutionnaires qui accompagnent régulièrement le développement de la discipline.

1 | Lebrère M, « L’artialisation des sons de la nature dans les sanctuaires à automates d’Alexandrie, du IIIe s. av. J.-C. au Ier s. apr. J.-C. », Pallas, Revue d’études antiques, 2015, 98 :31-53.

2 | Roux S, Introduction de l’ouvrage L’automate – Modèle Métaphore Machine Merveille, Presses universitaires de Bordeaux, 2013.

3 | Poe EA, Le Joueur d’échecs de Maelzel, 1836 (traduction française de Charles Baudelaire). Sur bibebook.com

4 | Turing A, “On Computable Numbers, with an Application to the Entscheidungsproblem”, Proceedings of the London Mathematical Society, 1937, s2-42 :230-65.

5 | McCarthy J et al., “A proposal for the Dartmouth summer research project on Artificial Intelligence”, 1955, 13p. Voir AI Magazine, 2006, 27 :12-4.

6 | Turing A, “Computing Machinery and Intelligence”, Mind, 1950, 59 :433-60.

7 | Searle J, “Minds, brains, and programs. Behavioral and Brain”, Sciences, 1980, 3 :417-24.

8 | Simon HA, Newell A, “Heuristic problem solving : The next advance in operations research”, Operations Research, 1958, 6 :1-10.

9 | Simon HA,The shape of automation for Men and Management, Harper, 1965.

10 | National Research Council, Language and Machines : Computers in Translation and Linguistics, The National Academies Press, 1966, doi.org/10.17226/9547.

11 | Campbell NA et al., “Recognition of a Hidden Mineral Deposit by an Artificial Intelligence Program”, Science, 1982, 217 :927-9.

12 | Yu VL et al.,“Antimicrobial selection by a computer. A blinded evaluation by infectious diseases experts”, JAMA, 1979, 242 :1279-82.

1 Malheureusement, inachevée de son temps et qui ne fonctionna jamais réellement.

2 Toutes les traductions depuis l’anglais sont de la rédaction.

3 Le film sur la vie de Turing, Imitation Game (Le jeu de l’imitation), reprend cette expression.

4 En modélisation, une « boîte noire » est un système dont on ne considère pas le fonctionnement interne, qui est masqué ou inaccessible : à partir d’« entrées », l’utilisateur peut produire des « sorties » mais n’a pas accès aux mécanismes produisant ces dernières.

Publié dans le n° 332 de la revue

Partager cet article

L'auteur

Jean-Paul Krivine

Rédacteur en chef de la revue Science et pseudo-sciences (depuis 2001). Président de l’Afis en 2019 et 2020. (…)

Plus d'informationsIntelligence Artificielle

L’intelligence artificielle (IA) suscite curiosité, enthousiasme et inquiétude. Elle est présente dans d’innombrables applications, ses prouesses font régulièrement la une des journaux. Dans le même temps, des déclarations médiatisées mettent en garde contre des machines qui pourraient prendre le pouvoir et menacer la place de l’Homme ou, a minima, porter atteinte à certaines de nos libertés. Les performances impressionnantes observées aujourd’hui sont-elles annonciatrices de comportements qui vont vite nous échapper ?

Intelligence artificielle générale : entre fantasmes et réalité

Le 21 septembre 2025

Intelligence artificielle : conscience, autonomie et risques existentiels

Le 20 novembre 2025

La controverse autour de Luc Julia sur l’intelligence artificielle

Le 2 septembre 2025

IA génératives : une révolution en cours ?

Le 17 octobre 2023

![[Quimper - Jeudi 7 mai 2026] Faut-il craindre l'intelligence artificielle ?](local/cache-gd2/aa/44527a70f7a9581abc0ebe20d9c129.jpg?1768404452)