Le principe anthropique

Publié en ligne le 14 août 2014 - Épistémologie -Le « principe anthropique » énoncé en 1973 a suscité de nombreuses controverses et il est actuellement plus discuté que jamais, en particulier parce qu’il a été l’objet de nombreuses interprétations plus ou moins spiritualistes. Le but de cet article est de démystifier cette question considérée comme sulfureuse et dont de nombreux scientifiques pensent qu’elle doit rester du domaine de la métaphysique, de montrer qu’il n’est pas inutile de la poser et qu’on peut lui trouver des réponses rationnelles.

Ces nombres bizarres qui caractérisent l’Univers

Qu’est-ce que ce « principe anthropique » ? D’emblée, il faut préciser que ce n’est pas réellement un « principe » mais simplement une constatation de faits, et qu’il n’est pas non plus réellement « anthropique », car il ne s’agit pas de l’homme à proprement parler mais plutôt de la Vie sous toutes ses formes. Nous en verrons la définition plus loin.

Le terme a été inventé en 1973 par un jeune physicien de Cambridge (Angleterre), Brandon Carter, qui a ensuite vécu en France et a travaillé toute sa vie à l’Observatoire de Paris-Meudon. Il l’avait proposé au cours d’un colloque en Pologne célébrant le 500e anniversaire de la naissance de Copernic, dans le but de faire réfléchir à la validité de ce que l’on a appelé « le principe copernicien », à tort car Copernic lui-même ne l’aurait sans doute jamais exprimé ainsi. Le principe de Copernic signifie maintenant que nous ne sommes pas au centre de l’Univers mais dans une position tout à fait quelconque, l’Univers lui-même étant en moyenne identique en tout lieu (bien sûr, on sait que la matière est rassemblée en étoiles, en galaxies et en amas de galaxies, mais on sait également que l’on peut parler d’homogénéité à plus grande échelle).

Depuis des décennies, les physiciens de Cambridge avaient l’habitude de se poser des questions sur les paramètres de l’Univers. Après Arthur Eddington, le physicien Paul Dirac, qui a prédit l’existence du positron 1 et est à la source de la découverte de l’antimatière, s’interrogeait dans les années 1930 sur d’étranges coïncidences qu’il trouvait entre les valeurs de différentes constantes physiques, et il les interprétait en émettant l’hypothèse qu’elles variaient au cours du temps 2. Peu de scientifiques y attachèrent de l’importance, et la plupart accusèrent Dirac de faire de la numérologie (ils allèrent jusqu’à dire que son remariage l’avait rendu un peu fou !).

L’âge de l’Univers

Mais le ver était dans le fruit. La réponse à Dirac fut donnée en 1961 par le physicien Robert Dicke 3. Il souligna que ces coïncidences déterminaient l’âge de l’Univers, mais que celui-ci « n’est pas une valeur aléatoire parmi une large gamme de valeurs possibles, elle est limitée par les critères rendant possible l’existence de physiciens ». Cette phrase, que l’on prend souvent pour une galéjade, a pourtant un sens profond.

Dans les années 1950, un groupe de quatre astrophysiciens (dont trois de Cambridge !) se posaient la question de l’origine des différents éléments constituant l’Univers et montraient qu’ils devaient être synthétisés au cœur des étoiles par des réactions nucléaires : par exemple un noyau de carbone se forme lorsqu’un noyau de béryllium rencontre un noyau d’hélium. Parmi eux, un scientifique remarquable aux idées souvent frondeuses : Fred Hoyle (ses romans de science-fiction étaient très prisés parmi les chercheurs de cette époque). Hoyle remarqua qu’il fallait pour cela qu’il existe un niveau du noyau de carbone situé à une énergie très précise, sinon la formation du carbone aurait pris un temps bien supérieur à la durée de vie de l’Univers 4. Hoyle demanda à son ami Willy Fowler, expérimentateur en physique nucléaire, de rechercher ce niveau et Fowler le découvrit presque immédiatement (notons que Fowler a eu le prix Nobel, et Hoyle non 5). À propos de cette « prédiction », Hoyle écrivit en 1957 cette phrase : « la position de ce niveau signifie que des créatures vivantes comme nous ne peuvent exister que dans une portion de l’univers où cette résonance existe ». Encore une idée bizarre !

Mais ce n’était pas tout. Cela signifiait que la Vie, qui nécessite la présence de carbone ou d’éléments plus lourds capables de fabriquer des molécules complexes, ne pouvait se développer avant que ces éléments aient été synthétisés dans les étoiles. Or, pour ceux qui, comme Dicke, croyaient au Big Bang (à cette époque, on n’avait pas encore découvert le rayonnement fossile qui en donna une preuve des plus solides), l’Univers avait un âge fini et les étoiles n’avaient pas existé de tout temps. La présence de la Vie exigeait donc que l’âge de l’Univers soit supérieur à des centaines de millions, voire des milliards d’années, le temps pour les étoiles de se former et d’arriver à fabriquer ces éléments, car ceux-ci sont synthétisés dans des étoiles relativement peu massives comme le Soleil, qui évoluent lentement. Par exemple le Soleil, qui s’est formé neuf milliards d’années après le Big Bang, commencera à fabriquer du carbone et de l’oxygène dans environ quatre milliards d’années. Il deviendra alors une immense étoile rouge dont le rayon s’étendra presque jusqu’à la Terre, avant de se transformer en une minuscule naine blanche, et il projettera dans l’espace des vents puissants contenant ce carbone et cet oxygène, qui seront alors disponibles pour fabriquer les indispensables molécules. C’est exactement ce qu’exprimait l’aphorisme de Robert Dicke. Celui-ci allait même plus loin en prédisant que dans quelques milliards d’années, la plupart des étoiles seraient « mortes » par manque de combustible nucléaire et que la Vie disparaîtrait alors de l’Univers. Il en déduisait donc que l’âge de l’Univers ne pouvait avoir d’autre valeur que comprise entre dix et vingt milliards d’années, car sinon nous ne serions pas là pour en débattre ! Nous savons maintenant que l’Univers est âgé de 13,8 milliards d’années.

Principe anthropique et Big Bang

En 1973 donc, Brandon Carter invitait les astronomes à méditer sur ces idées, en énonçant deux formes de ce qu’il appela le Principe Anthropique :

– Le principe faible (WAP pour Weak Anthropic Principle) : « Les conditions que nous observons autour de nous sont nécessaires à notre existence. » Il fut qualifié aussitôt de « tautologie ». Ce n’est pourtant pas le cas, comme nous allons le voir.

– Le principe fort (SAP pour Strong Anthropic Principle) : « Les paramètres fondamentaux caractéristiques de l’Univers doivent être tels qu’ils ont permis l’émergence d’observateurs à une certaine étape de son évolution ». Cette formulation a été mal comprise, à cause du terme « doivent » (« must » en anglais) et a été interprétée comme « l’Univers a été conçu dans le but de générer des observateurs », ce qui n’était pas du tout l’idée de Carter 6.

On vit immédiatement de nombreux colloques pseudo-scientifiques fleurir sur le sujet. Des livres furent publiés, dont le plus approfondi, en 1986, fut celui de Barrow et Tipler, The Anthropic Cosmological Principle. Ils y définissaient en particulier un nouveau principe, le FAP, pour « Final Anthropic Principle » : « À partir du moment où l’intelligence a émergé, elle subsistera indéfiniment ». Ce principe, ainsi que les autres d’ailleurs, fut donc violemment moqué, et un scientifique alla jusqu’à proposer le concept de « CRAP », pour « Completely Ridiculous Anthropic Principle » (il faut savoir que « crap » est un mot très inconvenant en anglais !).

Par ailleurs, une découverte des années 1970 allait révolutionner en même temps la cosmologie et la physique des particules : on s’aperçut que ces deux domaines, c’est-à-dire celui de l’infiniment grand et celui de l’infiniment petit, étaient fondamentalement liés. Car c’est dans le brasier effroyablement chaud et dense de l’Univers primordial, lorsque sa température était de centaines de milliards de degrés, que s’élaborèrent les premières particules et même que se manifestèrent les forces de la nature. Et c’est pendant les trois premières minutes après le Big Bang que se fabriquèrent les noyaux d’hydrogène, d’hélium et de béryllium, qui allaient, des milliards d’années plus tard, se souder dans les cœurs des étoiles pour donner le carbone et l’oxygène. Certains se posèrent alors la question : mais que se serait-il passé si les particules et les forces avaient été différentes de ce qu’elles sont ? Les étoiles auraient-elles synthétisé du carbone et de l’oxygène ? Auraient-elles vécu suffisamment longtemps pour permettre aux planètes comme la Terre d’engendrer la Vie ?

Les forces et les constantes qui régissent l’Univers

On connaît (pour le moment !) quatre forces – ou « interactions » – de la nature. La seule que nous ressentons est la force gravitationnelle, qui nous paraît la plus grande puisque c’est elle qui nous maintient à la surface de la Terre. Paradoxalement, cette force est de loin la plus faible, de très loin même puisque la force électromagnétique, par exemple, est 10 à la puissance 39 fois plus grande ! Et c’est justement parce que la force gravitationnelle est aussi faible que les étoiles peuvent rayonner pendant suffisamment longtemps pour permettre à la Vie de naître sur les planètes (voir encadré).

Outre la force gravitationnelle, il existe trois autres interactions.

La force électromagnétique qui s’exerce sur les particules chargées électriquement, qu’on connaissait déjà au début du vingtième siècle. Elle gouverne notre vie quotidienne, nos appareils électriques, nos téléphones, etc. Elle se fait sentir à l’échelle des atomes. C’est en fait déjà l’unification de deux interactions, l’électrique et la magnétique.

La deuxième est la force nucléaire faible responsable d’une partie de la radioactivité. On l’a découverte dans les années 1930, et elle agit sur des distances minuscules, inférieures à la taille des noyaux des atomes, eux-mêmes mille fois plus petits que les atomes eux-mêmes. La force faible, contrairement aux autres, est donc une force de dissension et non de cohésion.

Dans les années 1970, on a compris l’origine d’une troisième force que l’on connaissait depuis longtemps, mais dont le statut a alors changé : l’interaction forte ou nucléaire qui maintient les particules comme les quarks à l’intérieur d’un noyau, à l’aide de particules « colle » qu’on appelle les « gluons ».

Ces trois forces sont bien plus importantes que la gravité dans le monde subatomique. En effet, la force électromagnétique décroît avec la distance de la même façon que l’attraction gravitationnelle, mais son intensité est considérablement plus grande. Si elle ne joue aucun rôle dans les astres, c’est parce qu’ils sont électriquement neutres, tandis qu’elle s’exerce seulement entre des corps chargés. Quant aux deux autres interactions, elles sont également beaucoup plus fortes que la gravité mais elles ont une très petite portée.

La gravité l’emporte donc sur les autres forces seulement pour les grandes masses. Si elle était 100 fois plus forte, par exemple, les planètes seraient de simples astéroïdes, seules des mini-étoiles se formeraient, et elles vivraient 100 fois moins longtemps. Clairement, la Vie ne pourrait se développer.

On a pu montrer (en particulier Weinberg cité dans le texte), et cela a été vérifié avec une précision spectaculaire dans les grands accélérateurs, que la force électromagnétisme et l’interaction faible sont « unifiées » à haute énergie dans l’interaction « électrofaible ». On en déduit qu’elles se sont séparées environ un dix milliardième de seconde après le Big Bang. On pense que l’interaction forte a également été unifiée avec l’interaction électrofaible encore plus tôt dans l’Univers primordial, et le Graal des physiciens est actuellement de trouver le moyen d’unifier ces trois interactions avec la gravité, à travers la théorie des cordes.

On peut raisonner de la même façon pour les autres interactions. Si la force nucléaire forte était plus grande de 2 %, l’hydrogène disparaîtrait en quelques minutes, il n’y aurait pas d’éléments plus légers que le fer. Si elle était plus petite, aucun élément plus lourd que l’hydrogène et l’hélium ne se formerait. Dans les deux cas, aucune molécule ne pourrait se former. Si la force électromagnétique était un peu plus grande, les électrons repousseraient les autres atomes. Si elle était plus petite de quelques pourcents, ils ne seraient pas maintenus dans leur atome. Encore une fois, dans les deux cas, il n’y aurait pas de molécule.

Du côté des constantes de la physique, c’est le même constat. Il en existe une vingtaine, dont la valeur est déterminée expérimentalement avec une très grande précision, comme la vitesse de la lumière, la constante de la gravitation, la masse de l’électron, etc., mais dont nous ignorons pourquoi elles ont ces valeurs. Si elles avaient différé de leur valeur par des quantités minimes, l’Univers aurait subi une autre évolution et il n’y aurait pas eu de vie non plus. Par exemple, la formation du deutérium dépend crucialement de la différence des masses des neutrons et des protons, or le deutérium est indispensable à la formation de l’hélium, lui-même indispensable à la formation du carbone.

De tout cela est née l’idée que l’Univers a été réglé d’une façon « incroyablement précise » dans le but de permettre l’émergence de la Vie. Cette version biaisée du Principe Anthropique Fort a été utilisée pour asseoir ce que l’on a appelé « le Grand Dessein » ou « le Dessein Intelligent », prônant qu’une intelligence supérieure (un Grand Architecte) a créé l’Univers dans le but d’y accueillir les hommes. L’idée a été popularisée par des livres comme La mélodie secrète de l’astrophysicien Thuan, qui a eu un grand succès public. Mais contrairement à ce que certains scientifiques affirment – malhonnêtement à mon avis – très peu de spécialistes de cosmologie y adhèrent. Elle a cependant fait florès aux États-Unis dans les milieux religieux où elle a été utilisée pour justifier « scientifiquement » le créationnisme. En France, où la croyance au créationnisme est heureusement moins développée qu’aux États-Unis, le Grand Dessein commence cependant à faire des émules, grâce en particulier à l’Université Interdisciplinaire de Paris 7 qui comprend quelques chercheurs de renom et qui est financée en partie par la fondation nord-américaine Templeton. Celle-ci distribue des prix somptueux aux scientifiques qui tentent de faire le lien entre la science et la foi par le biais du Grand Dessein.

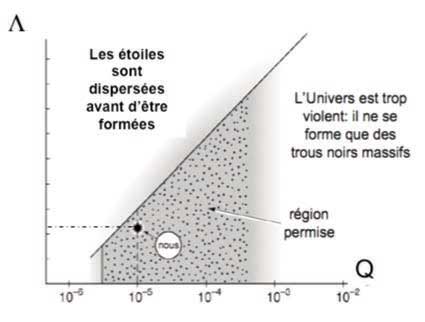

Mais est-il raisonnable de supposer qu’une seule constante pourrait être différente, les autres restant égales par ailleurs ? Pour répondre à cette question, des physiciens essayent de coupler les constantes au moyen de théories « non standard » de la physique, et montrent que les contraintes sont alors moins fortes. Certains vont même jusqu’à affirmer qu’un Univers auquel manquerait l’une des interactions (la « faible ») pourrait néanmoins produire la Vie. Et dans un cas précis où il a été possible de « faire varier » deux constantes, on constate que l’intervalle anthropique est beaucoup plus vaste (voir encadré sur la constante cosmologique).

On peut donc conclure que, certes, les valeurs des constantes sont contraintes, mais pas d’une façon « incroyablement précise ».

Cette constante, qui peut être nulle, est prévue dans la solution des équations de la Relativité Générale. Einstein lui-même en avait tenu compte dans son premier modèle d’Univers, et il avait supposé pour des raisons purement philosophiques qu’elle avait une valeur telle que l’Univers était statique et non en expansion. Il a considéré que c’était la « plus grande erreur de sa vie » ! On l’a donc abandonnée pendant des décennies avant de découvrir récemment qu’elle existe, mais pas du tout pour les mêmes raisons que celles d’Einstein.

Son existence a en effet été découverte en 1998 grâce à l’observation d’étoiles très lointaines (des supernovae), et elle a été confirmée depuis par d’autres observations. Elle agit comme une force répulsive contrebalançant la gravité et produisant une accélération de l’expansion de l’Univers : on l’appelle en général « énergie sombre », et l’on en ignore encore la nature. Pourquoi sa valeur est-elle très faible, sans être nulle ? Si elle avait été un peu plus grande, l’Univers aurait été soufflé en quelques minutes ou en quelques années. Le physicien américain et prix Nobel Steven Weinberg avait d’ailleurs estimé il y a plus de trente ans que la constante cosmologique devait avoir une valeur très petite car si elle était plus grande, l’Univers n’aurait pas pu produire d’étoiles ou de galaxies. Il déduisait une valeur très proche de celle que l’on a observée quinze ans plus tard ! On peut donc considérer que c’était une véritable « prédiction anthropique ».

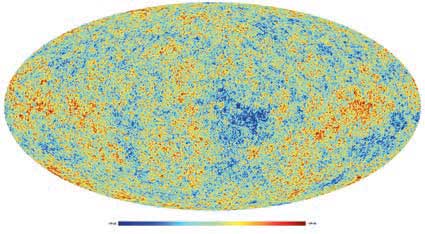

Weinberg avait utilisé pour faire sa démonstration le fait que l’on observe des fluctuations dans le fond diffus cosmologique micro-onde (ce fameux rayonnement fossile qui nous parvient des débuts de l’Univers). Ce fond diffus présente des fluctuations minuscules, de l’ordre du cent millième du fond lui-même1. Or ce sont ces fluctuations, amplifiées par la gravité, qui ont donné par la suite naissance aux étoiles et aux galaxies. Si l’on suppose que non seulement la constante cosmologique mais également la valeur moyenne de ces fluctuations étaient toutes deux différentes de ce qu’elles sont, on trouve qu’il existe tout un ensemble de valeurs permettant l’éclosion de la Vie (voir la figure).

1 Sur les images publiées du fond diffus, comme celle obtenue récemment par le satellite Planck, ces fluctuations en fausses couleurs sont considérablement intensifiées pour apparaître clairement.

Un Grand Architecte n’est pas nécessaire !

Quelles explications les scientifiques proposent-ils au principe anthropique ? La plus répandue est qu’il s’agit d’un simple hasard, de même qu’un jet de deux dés produirait un double six, sur 36 possibilités, si tant est que l’homme puisse se considérer comme un double six... Ou bien que la Vie pourrait prendre des formes beaucoup plus variées qu’on ne l’imagine.

Une autre est que l’on pourra un jour expliquer la valeur des forces et des constantes à l’aide d’une théorie unique, la « Théorie du Tout ». Mais outre qu’elle semble encore bien éloignée, elle ne me paraît pas résoudre le problème, qu’elle repousse seulement davantage à un niveau plus profond.

Une troisième interprétation est celle du « multivers ». Elle est très à la mode parmi les cosmologistes travaillant sur la théorie des « supercordes », celle qui cherche à unifier la gravité avec les autres interactions. En effet, toute tentative pour comprendre l’origine de l’Univers bute dans le passé sur le moment où il avait une densité si énorme que la gravité elle-même était un phénomène quantique. La théorie des supercordes prédit qu’il devrait exister non pas UN Univers, mais un très grand nombre, chacun correspondant à un Big Bang différent, avec ses propres constantes. La plupart de ces univers n’auraient pas les bonnes constantes mais un certain nombre serait « vivable », et le nôtre en ferait partie, un peu comme si, pour poursuivre l’illustration, 36 paires de dés avaient été jetées, chacune avec un résultat différent : le double 6 est là, au milieu des autres, et nous « habitons » le double 6. Cette idée se situe dans la continuité d’une progression historique : au seizième siècle, le géocentrisme est abandonné, au dix-neuvième siècle le Soleil devient une étoile parmi des centaines de milliards d’autres, au vingtième siècle, la Voie Lactée devient une galaxie parmi des centaines de milliards d’autres, alors pourquoi notre Univers ne serait-il pas l’un parmi des milliards d’autres ?

Une variante de l’idée de multivers est fondée sur la théorie concurrente, la « gravité quantique à boucle », qui prédit, elle, un univers ayant rebondi après sa contraction au lieu d’une multiplicité d’univers. Cette théorie pourrait correspondre en fait à un univers cyclique dont les caractéristiques varieraient à chaque cycle (avec la même illustration, cela signifie qu’à chaque cycle, les dés sont relancés, et que parfois un double 6 sort). Nous serions dans un « bon » cycle.

Dans les deux cas, on donne une réponse au principe anthropique faible, qui n’est clairement pas une simple tautologie, et conduit même à remettre en cause le principe copernicien. Le problème est qu’aucune de ces deux théories n’est encore aboutie à l’heure actuelle et n’a débouché sur une prédiction observable. Pourtant, il n’est pas exclu que la présence d’autres univers ou d’un rebond ayant précédé le Big Bang puisse se traduire par des observations sur le fond diffus cosmologique.

Une dernière interprétation qui commence à monter en puissance est celle de « l’émergence ». Elle remet en cause le raisonnement scientifique habituel, fondé sur le réductionnisme. L’émergence se caractérise par l’apparition de lois qui ne peuvent être déduites de principes physiques plus fondamentaux. Comme on a l’habitude de le dire : « l’ensemble fait plus que la somme de ses parties ». Les lois émergeraient lorsqu’un niveau de complexité est franchi, sans pouvoir être prédites à partir du niveau précédent. Ainsi, les lois qui gouvernent la biologie ne sont pas réductibles à la chimie moléculaire, ni la chimie moléculaire à la physique. Mais où s’arrêter ? Certains pensent par exemple qu’une force aussi fondamentale que la gravitation serait elle aussi émergente. Allant encore plus loin, d’autres (et non des moindres), proposent de se poser la question d’un évolutionnisme en cosmologie comparable au néodarwinisme en biologie. Ces idées n’en sont cependant qu’à leurs balbutiements, et ne sont pour le moment étayées par aucune théorie sérieuse.

Des erreurs fécondes 8

Évidemment, tout cela donne l’impression d’une énorme cacophonie. Et l’on a beau jeu de crier haro sur la science qui se permet de dire n’importe quoi et son contraire, oubliant que c’est précisément parce qu’elle se cherche qu’elle emprunte de nombreux chemins. Et que c’est une preuve de vitalité que de discuter et de chercher la faille dans la théorie du voisin. Que se serait-il passé si à l’aube du vingtième siècle les physiciens avaient déposé les armes devant les apparentes inconsistances qui se présentaient à leurs yeux ? Aucune de ces deux grandes révolutions de la pensée qu’ont été la Mécanique Quantique et la Relativité Générale n’auraient eu lieu.

Et, aux tristes Cassandre qui nous prédisent que l’homme ne pourra jamais comprendre l’Univers, que les cosmologistes se trompent depuis cinquante ans et que le Principe Anthropique est une ineptie, ne peut-on répondre qu’il mérite pourtant l’attention (au moins sous sa forme dite « faible ») parce qu’il a montré sa vitalité en stimulant de nombreuses recherches, et qu’il pourra peut-être permettre de discriminer entre différents modèles cosmologiques. Gardons à l’esprit ces paroles du grand scientifique britannique Lord Kelvin à la fin du dix-neuvième siècle : « La Science est tenue de faire face sans frayeur à chaque problème qui se présentera sur sa route. »

1 Le positron est l’anti-particule de l’électron. Il lui est identique, mais possède une charge électrique positive au lieu d’être négative.

2 On a appelé cela « l’hypothèse des grands nombres de Dirac ». Dirac montrait par exemple que le rapport entre la taille de l’Univers observable et celle d’une particule quantique est égal à 10 à la puissance 39, et qu’il est égal au rapport entre la force électromagnétique et la force gravitationnelle exercée par un proton sur un électron.

3 Celui-là même qui, ayant construit quelques années plus tard un appareil pour détecter le rayonnement fossile du ciel prédit dans le cadre du Big Bang, rata de peu sa découverte : elle valut le prix Nobel aux deux ingénieurs qui le découvrirent par hasard.

4 De même que les atomes ont des niveaux d’énergie quantifiés qui sont à l’origine des raies spectrales, les noyaux ont des niveaux d’énergie également quantifiés. Dans le cas présent, c’est parce qu’un niveau du noyau de carbone a une énergie exactement égale à la somme de l’énergie du béryllium et de l’hélium que la réaction a lieu : c’est ce que l’on nomme une « résonance ».

5 Fowler n’a évidemment pas eu le Nobel pour cette seule découverte expérimentale mais pour l’ensemble de son œuvre en astrophysique nucléaire. En 1957, avec Hoyle et Margaret et Geoffrey Burbidge, il avait écrit un article fondateur en la matière mais il est le seul à avoir reçu le Nobel bien que Hoyle l’eût également mérité et l’eût sans doute obtenu s’il n’avait pas – de même que les Burbidge – professé ses idées sur l’univers stationnaire et s’il n’avait pas eu des altercations avec le comité Nobel...

6 Carter croyait à la théorie des « mondes multiples » fondée sur la mécanique quantique, proposée par le physicien Hugh Everett en 1957.

8 Voir « Des erreurs fécondes », Georges Jobert – SPS n° 302, octobre 2012.)

Publié dans le n° 307 de la revue

Partager cet article

L'auteur

Suzy Collin-Zahn

Astrophysicienne et directeur de recherche honoraire à l’Observatoire de Paris-Meudon.

Plus d'informationsÉpistémologie

L’histoire est-elle une science ?

Le 31 mai 2023

Qu’est-ce que la science ?

Le 4 septembre 2021

Mario Bunge (1919-2020)

Le 9 avril 2021

Histoire de l’âge de la Terre

Le 7 novembre 2017